Guías

Qué es HDR y cómo mejora la experiencia en juegos o vídeos

El ojo humano es la base del sentido de la vista y funciona transformando la energía lumínica que recibe en señales eléctricas que envía al cerebro. Su capacidad para adaptarse a cualquier condición de luminosidad, manteniendo colores y contraste, es extraordinaria. Ninguna máquina construida por el hombre ha sido capaz de igualar su potencial, pero hay tecnologías que intentan acercarse a lo conseguido por la visión humana como las que llegan del HDR.

Antes de empezar, decir que los genios del marketing han conseguido introducir esta tecnología hasta en la sopa como suelen hacer con cualquier concepto que tenga tirón entre los consumidores. De esta manera, hoy la verás «soportada» en todo tipo de productos, tanto los que son capaces de recrearla como cámaras fotográficas, de vídeo o móviles o aquellos donde se representa el contenido, pantallas de visualización como televisores o monitores informáticos.

No es oro todo lo que reluce y su implementación varía muchísimo, desde los productos que -aunque lo prometan- no ofrecen nada por encima del SDR (rango dinámico estándar) a los que sí son capaces de mejorar la experiencia en tareas masivas como juegos o vídeos. Te ponemos en situación para que puedas distinguirlos.

Qué es HDR

Traducida como alto rango dinámico desde sus siglas en inglés, es una tecnología que tiene el objetivo de conseguir recrear imágenes digitales (fijas o en movimiento) lo más cercanas posibles a lo que el ojo humano vería en el mundo real. Aunque parezca algo novedoso, se conocen intentos de fotografías de alto rango dinámico desde 1850 usando varias exposiciones, lo único que podían usar los genios de la época ante sus enormes limitaciones técnicas.

Ya en las décadas de 1930 y 40 se mejoraron usando la misma idea inicial, varias capas de películas expuestas para lograr una sola imagen final que reflejara los cambios de luz que son perceptibles por el ojo humano. La era de los gráficos por ordenador iniciada en los 80 fue un antes y un después, mientras que el aumento de capacidad de procesamiento de las computadoras actuales ha permitido desplegar su potencial.

Las investigaciones médicas sobre el funcionamiento del ojo humano; nuevas técnicas como el mapeo de tonos; la mayor amplitud de las gamas de color; el aumento del brillo máximo; los negros más oscuros para las sombras, junto con relaciones de contraste más equilibradas, han conseguido grandes avances en esta función y con ello lograr que las imágenes digitales se perciban lo más realistas y precisas, acercándose a lo que el ojo humano vería en el mundo real.

HDR en monitores y televisores

En términos de pantallas de visualización, hay varios formatos de vídeo HDR que debes conocer, con tres principales: HDR10, HDR+ y Dolby Vision. Estos perfiles de medios se aplican tanto a cómo se graba o renderiza el contenido como a la capacidad de mostrarlo en las pantallas que lo soportan y que son las protagonistas de este artículo.

Aunque todas apuntan a lo mismo, mostrar imágenes más realistas, tienen diferentes requisitos, especificaciones y propiedades, y sus resultados son bastante distintos. También difieren en términos de costes de licencia, función de transferencia, metadatos y compatibilidad, pero para que te hagas una idea, exigen un mínimo de 10 bits en el panel y mapeado de tonos. Te dejamos con los criterios esenciales de los distintos perfiles, que en definitiva van a definir si cumplen o no con HDR:

Profundidad de bits

De manera general los monitores informáticos, las pantallas de los portátiles, los televisores y el resto incluidas las de los teléfonos inteligentes, utilizan colores de 8 bits. Ello les permite mostrar 16,7 millones de colores. Las pantallas HDR aumentan la profundidad a 10 o 12 bits, lo que les permite mostrar 1.070 y 68.700 millones de colores, respectivamente. Para que una pantalla se califique como HDR10 y HDR10+ debe mostrar una profundidad de color de 10 bits, mientras que Dolby Vision admite 12 bits. No conocemos ninguna pantalla para consumo con 12 bits, por lo que los 10 bits es el máximo actual de la industria.

Brillo máximo

Es la cantidad mínima de luminancia máxima que puede alcanzar una pantalla con HDR. Para que las pantallas puedan mostrar imágenes de rango dinámico necesitan niveles de brillo más altos que las pantallas normales, las SDR (rango dinámico bajo). El brillo máximo se mide en cd / m² y para HDR tiene que ser al menos de 400 cd / m². Todo lo que veas por debajo, olvídate, no será capaz de ofrecer imágenes de alto rango dinámico.

Brillo negro máximo

Para acercarse a la realidad, además de un pico de luminancia alto para áreas de imagen brillantes, también deben poder mostrar áreas oscuras usando negros muy oscuros. Ahí es donde entra en juego este parámetro. Los valores típicos de este atributo son inferiores a 0,4 cd / m², pero no existe ningún requisito en lo que respecta a los protocolos HDR. Sin embargo, el estándar DisplayHDR propuesto por VESA y del que hablaremos después, sí tiene valores específicos y considera que cualquier pantalla que pueda mostrar negros con un brillo inferior a 0,0005 cd / m² se considera True Black.

Mapeo de tonos

El contenido creado con HDR como películas o juegos, tiene valores de brillo mucho más altos que los que puede mostrar una pantalla de consumo. Algunas secuencias de una película superan sin problemas los 1.000 cd / m², pero entonces ¿cómo se maneja en una pantalla de nivel inferior? Aquí entra otra de las técnicas que se usan actualmente, el mapeo de tonos, que usa algoritmos para reducir el brillo del contenido filmado para adecuarse al máximo que puede mostrar la pantalla. En este escenario valores como el contraste se resienten, aunque las pantallas siguen mostrando más y mejores detalles que las SDR.

Metadatos

El contenido creado con HDR almacenan información en unos metadatos. Los dispositivos los usan en su reproducción para decodificar correctamente el contenido. El problema es que no todos los formatos utilizan el mismo tipo de metadatos. HDR10 utiliza metadatos estáticos, lo que significa que la configuración aplicada a cómo se muestra el contenido es la misma desde el principio hasta el final. HDR10+ y Dolby Vision, usan metadatos dinámicos, lo que significa que las imágenes mostradas se pueden ajustar sobre la marcha, usando diferentes rangos de brillo en diferentes escenas, o incluso para cada fotograma de un vídeo.

HLG

Hybrid Log Gamma y representa un estándar HDR que permite a los distribuidores de contenido como las empresas de televisión, ofrecer contenido televisivo tanto en SDR como en HDR utilizando una sola emisión. Cuando esa transmisión llega al televisor o monitor, el contenido se muestra en uno de ellos, según el soporte de la pantalla.

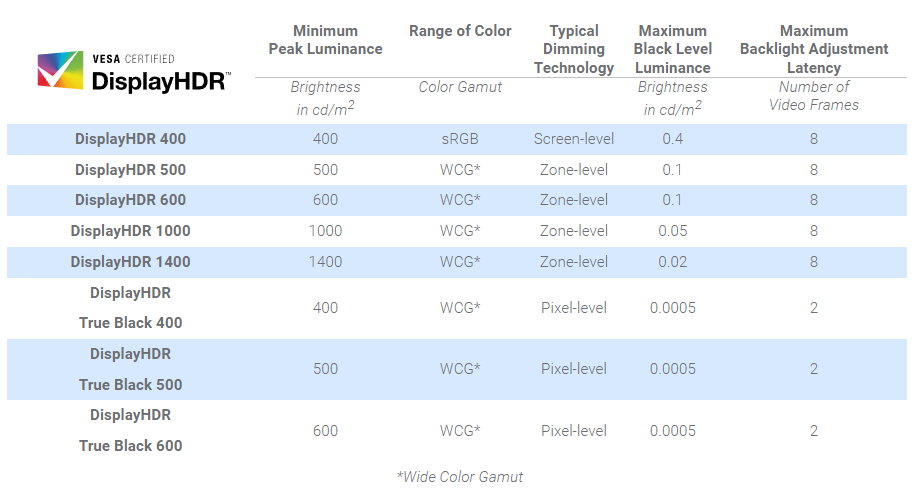

DisplayHDR, el estándar de VESA

Es el estándar propuesto por la asociación internacional de fabricantes de electrónica VESA para manejar el HDR en pantallas de visualización. Está conectado con los formatos que vimos anteriormente, pero son distintos y lo que hace VESA es certificar un nivel de rendimiento mínimo que garantice la calidad en la entrega del contenido de alto rango dinámico y diferenciarlos de los típicos SDR (rango dinámico estándar).

La asociación incluye a todos los grandes fabricantes de pantallas, de PCs, de componentes relacionados como chips gráficos o de sistemas operativos como Microsoft, por lo que es una buena referencia a la hora de adquirir dispositivos y proteger así a los usuarios de la publicidad engañosa que no falta en el marketing tecnológico. La asociación ha definido las certificaciones de DisplayHDR por niveles y la siguiente imagen muestra sus características principales.

DisplayHDR 400

Es el mínimo absoluto para obtener la certificación de rango dinámico y coincide con el formato HDR10 en exigir un brillo de 400 nits. Todo lo que esté por debajo de ese nivel de luminancia no es HDR. En cuanto la gama de color exige el estándar rojo-verde-azul (sRGB), con una luminancia de niveles de negro de solo 0,4 cd/m2. Este es el nivel básico en monitores y el más usado en pantallas de portátiles.

DisplayHDR 600

El siguiente nivel exige un mínimo de 600 nits de brillo. Además, rebaja la luminancia de niveles de negro a solo 0,1 cd/m2 lo que se notará especialmente en el contraste. Incluye una gama de colores más amplia (WCG), ampliando el espectro cromático mediante la retroiluminación y usando las zonas de atenuación local para dividir la luz de fondo del monitor e iluminarlas de forma diferente según la imagen mostrada en la pantalla.

DisplayHDR 1000

Para los que busquen las imágenes más realistas y espectaculares, mejora el nivel de brillo hasta 1000 nits y la luminancia de niveles de negro a solo 0,05 cd/m2. Como el anterior incluye zonas de atenuación local pero con muchas más áreas de brillo variable. Los nombrados son los niveles más importantes y reconocibles del estándar, pero existen otros intermedios como DisplayHDR500 y otros superiores como DisplayHDR 1400, con más brillo y menos luminancia en niveles de negros.

DisplayHDR «True Black»

Son versiones especiales de la norma que permiten niveles de negro hasta 100 veces más profundos y mayor rango dinámico. El más avanzado es el DisplayHDR True Black 600, que exige un mínimo de 600 nits de brillo. Además, rebaja la luminancia de niveles de negro a solo 0,0005 cd/m2 lo que se notará especialmente en el contraste. Incluye una gama de colores más amplia (WCG), ampliando el espectro cromático mediante la retroiluminación y usando las zonas de atenuación local para dividir la luz de fondo del monitor e iluminarlas de forma diferente según la imagen mostrada en la pantalla.

HDR en juegos o películas

Más allá de normas y características técnicas, lo más interesante para los usuarios llega de la capacidad de usar HDR en juegos o vídeos o en tareas profesionales como edición fotográfica o ilustración.

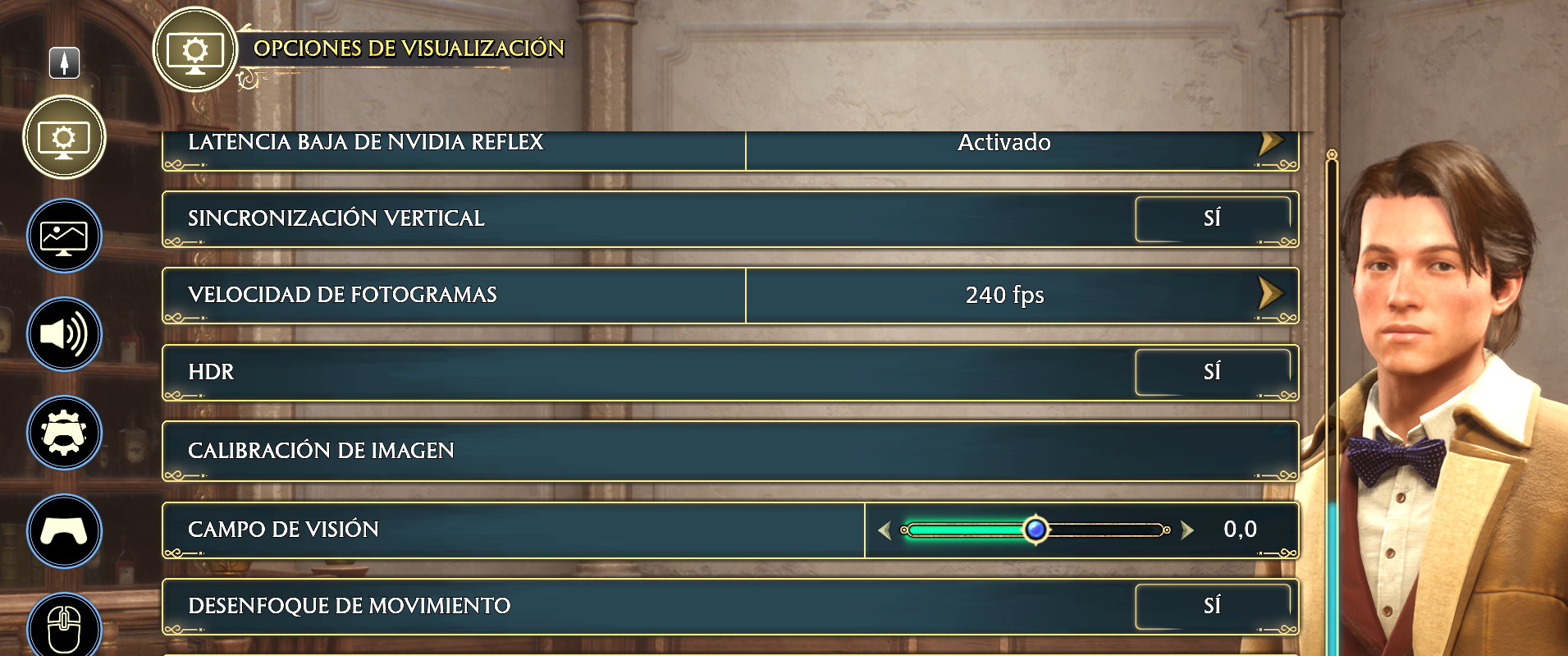

En juegos, decir que a nivel de desarrollo se usa renderizado con alto rango rango dinámico desde hace dos décadas y uno de los primeros acercamientos fue la expansión de Lost Coast para Half-Life 2. Hoy, cualquier juego 3D actual hace uso de esta función a la hora de crearlos, aunque no todos están disponibles a la hora de jugarlos. No hay tantos como nos gustaría, pero cada vez hay más. La mayoría de casos solo proporcionan un interruptor de encendido/apagado, mientras que los más avanzados proporcionar configuraciones adicionales para ajustar el procesamiento según las capacidades de la pantalla.

A modo de acercamiento, que no con un HDR real que solo puede proporcionar el desarrollador del juego y -obviamente- el fabricante de la pantalla, Microsoft estrenó en Windows una función de Auto HDR que, a grandes rasgos, es la misma tecnología que se puede encontrar en las consolas Xbox Series, y al igual que en la misma, lo que hace es mejorar la calidad del contenido en juegos pese a que éstos no hayan sido desarrollados contando con dicha tecnología, siempre que se basen en Direct X 11 o Direct X 12.

Potencialmente serán más de 1000 juegos los soportados, pero repetimos, no es un HDR real. Por lo que hemos probado hasta ahora, los resultados de Auto HDR son variados, con algunos juegos que no cambian nada, mientras que otros se transforman bastante. Dependerá de cuántos sombreadores de alta precisión y objetivos de renderizado se utilicen antes de aplicar cualquier asignación de tonos. Lo ideal sería un HDR real, cada vez más cerca por el nivelazo que están alcanzando los monitores y la potencia de las gráficas dedicadas actuales.

En cuanto a vídeo, además de un monitor o televisor con soporte para HDR, necesitaremos que el contenido se haya codificado para esta tecnología y dispositivos de reproducción como los lectores Blu-ray modernos como mayor exponente o los dongles de Amazon, Apple o Google que lo soportan en alguna de sus normas.

En servicios de transmisión, Disney+, Netflix y Prime Video ofrecen contenido codificado en alguno de los formatos HDR, pero tendrás que activarlos en sus menús (algunos son de pago adicional) y contar con una buena conexión a Internet. Para verlo en PCs, el chip gráfico y el monitor deberá ser compatible con HDCP 2.2 y tener instalados los códecs HEVC. En PCs, Netflix solo admite transmisión 4K HDR en Edge y su aplicación dedicada en Windows, mientras que Disney+ y Prime Video funcionarán en la mayoría de los navegadores.

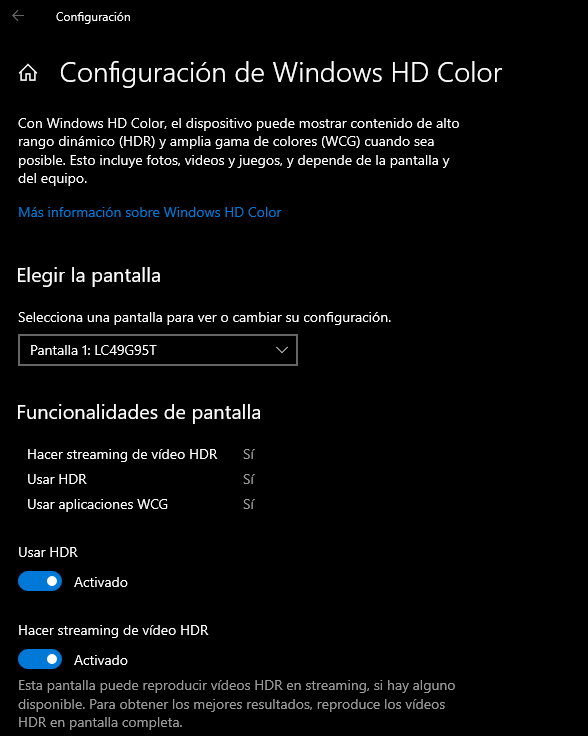

Cómo se activa el HDR en Windows

Windows 10 y Windows 11 ofrecen soporte para contenido de alto rango dinámico y en las versiones más recientes del sistema lo podrás ver definido como Windows HD Color. El objetivo es el comentado. Soportar las funciones mejoradas de brillo y color en comparación con el contenido tradicional de rango dinámico estándar o SDR.

Hay que decir que Windows realmente solo soporta hasta el formato HDR10 (paneles de 10 bits) y aún le queda mucho camino que mejorar, pero Microsoft está en ello por lo que hemos visto con el Auto HDR. El sistema operativo puede mostrar contenido de alto rango dinámico en fotografía, vídeos y juegos siempre que el hardware (tarjeta gráfica) y el monitor lo permita. Habilitarlo es muy sencillo como verás en la imagen. Si tu hardware lo soporta experimenta con ello.

Esperemos te sea útil este acercamiento a una tecnología que está ganando terreno en nuestros dispositivos electrónicos y que verás promocionada de manera masiva (no siempre tan real como promete). El ojo humano es inalcanzable, pero el HDR es lo más cercano al mundo real que podemos conseguir en imágenes digitales.

-

GuíasHace 3 días

GuíasHace 3 días10 sitios web para descargar libros electrónicos gratuitos

-

A FondoHace 5 días

A FondoHace 5 díasNovedades VOD 16/24: ‘Rebel Moon’, la película que deja marcas

-

A FondoHace 6 días

A FondoHace 6 díasTelefónica cumple 100 años, repasamos su historia

-

AnálisisHace 7 días

AnálisisHace 7 díasAnálisis ROCCAT Vulcan II Max: 6 meses al toque con un tope de gama