A Fondo

15 claves del evento Intel Innovation 2023

La semana pasada tuvo lugar la celebración del Intel Innovation 2023, uno de los eventos más importantes y más interesantes del año al que tuvimos la oportunidad de asistir, y la verdad es que este acabó superando nuestras expectativas tanto por la excelente ejecución como por la cantidad de sesiones y de demostraciones técnicas que tuvimos la oportunidad de disfrutar.

Fue un evento tan grande y tan amplio que no dejaba de sentir que me faltaban horas en el día para poder disfrutarlo. No tuve más remedio que elegir entre demostraciones y eventos que tenían lugar en horas similares o incluso simultáneas, lo que implicó renunciar a algunas cosas para poder disfrutar de otras, pero al final pude asistir buena parte de ellos y me vine a casa con una gran cantidad de información y de novedades interesantes que hoy quiero compartir con vosotros.

Podría dar forma a un artículo enorme recopilando todas las claves del evento, pero al final esto sería contraproducente porque las más interesantes quedarían «enterradas» entre grandes cantidades de texto, y daría forma a un artículo más difícil y pesado de leer. Con esto en mente, creo que lo mejor es adoptar el formato que he venido utilizando en artículos anteriores, y por ello voy a compartir con vosotros las 15 claves más importantes del Intel Innovation 2023.

1.-Intel quiere llevar la IA a todas partes

Si algo quedó claro durante el evento es que la IA es uno de los pilares centrales dentro de la estrategia de Intel a corto, medio y largo plazo, y lo es tanto a nivel de software como de hardware. Una parte fundamental en este sentido es la apuesta de Intel por llevar la IA a todas partes un objetivo tan ambicioso como complicado que el gigante del chip afronta con un amplio abanico de soluciones.

Entre dichas soluciones podemos destacar Intel Developer Cloud, que ofrece modelos de diferentes tamaños para afrontar diferentes cargas de desarrollo asociadas a inferencia y a la IA, incluyendo opciones más pequeñas y limitadas para derrumbar las barreras que impiden el acceso a los desarrolladores más pequeños.

OneAPI se mantiene como otra de las claves que harán posible la llegada de la IA a diferentes sectores y dispositivos, y también destacó durante el evento la entrada de Intel en la PyTorch Foundation, un movimiento que se ha confirmado solo un mes después de la entrada también del gigante de Santa Clara en la Linux Foundation AI & Data Foundation.

2.-Computación cifrada, de confianza y acelerada

El cifrado se ha convertido en algo fundamental para garantizar la seguridad de los datos en todas sus etapas, es decir, tanto cuando estos se encuentran en reposo como cuando están en tránsito o en uso. Durante esas tres fases que atraviesan los datos existen riesgos para la seguridad de los mismos, y el cifrado es una de las maneras más efectivas de protegerlos.

Sin embargo, al mover grandes cantidades de datos protegidos por cifrado homomórfico se produce un gran impacto a nivel de rendimiento. Intel es consciente de ello, sabe que es necesario contar con el hardware adecuado para evitar que este tipo de cifrado pueda saturar y generar problemas de rendimiento, y por ello ha confirmado que está trabajando en un acelerador ASIC (circuito integrado de aplicación específica) que reducirá la sobrecarga asociada a este tipo de cifrado.

Además de esto, Intel lanzará también la versión beta de un conjunto de herramientas de software para computación cifrada a finales de este año que irá dirigida a los desarrolladores. Interesante, pero la cosa no termina aquí, y es que el gigante del chip también habló de la importancia de la atestación, un servicio de verificación realizado por autoridades de confianza, como la propia Intel. Esto es lo que anteriormente conocíamos como Proyecto Amber.

En resumen, lo que hace este proceso de atestación es verificar la fiabilidad tanto del sistema operativo tanto del resto del software, asegurándose de que todos los elementos son lo que dicen ser. Para ello comprueba que el hardware es auténtico, que el firmware está correctamente actualizado y configurado y que el código de la aplicación no ha sido retocado o modificado. Todo esto se puede hacer sin importar dónde se encuentre el software, lo que significa que funciona tanto en la nube como en centros de datos privados e incluso en equipos de uso personal.

3.-Linux optimizado para Intel con la colaboración de RedHat, SUSE y Canonical

No es un secreto que Intel lleva años lleva años colaborando con el software libre para mejorar y optimizar las distros más populares con sus CPUs. Sin ir más lejos una de las empresas con las que más años lleva colaborando es Canonical, y esto ha dado fruto a diferentes imágenes de la distro Ubuntu optimizadas para diversos procesadores del gigante del chip.

En el evento Innovation de este año el gigante del chip ha ido más allá y ha anunciado una ampliación de su colaboración con los grandes del software libre, entre los que se encuentran nombres como Red Hat, Canonical y SUSE, para desarrollar y ofrecer distros Linux optimizadas para procesadores del gigante del chip, un movimiento que sin duda me parece muy inteligente.

Intel también seguirá apostando por el software libre y abierto, y realizará contribuciones importantes para optimizar y mejorar el rendimiento de diferentes frameworks y bibliotecas de trabajo, sobre todo el campo de la IA y el aprendizaje profundo, entre los que podemos destacar PyTorch y TensorFlow.

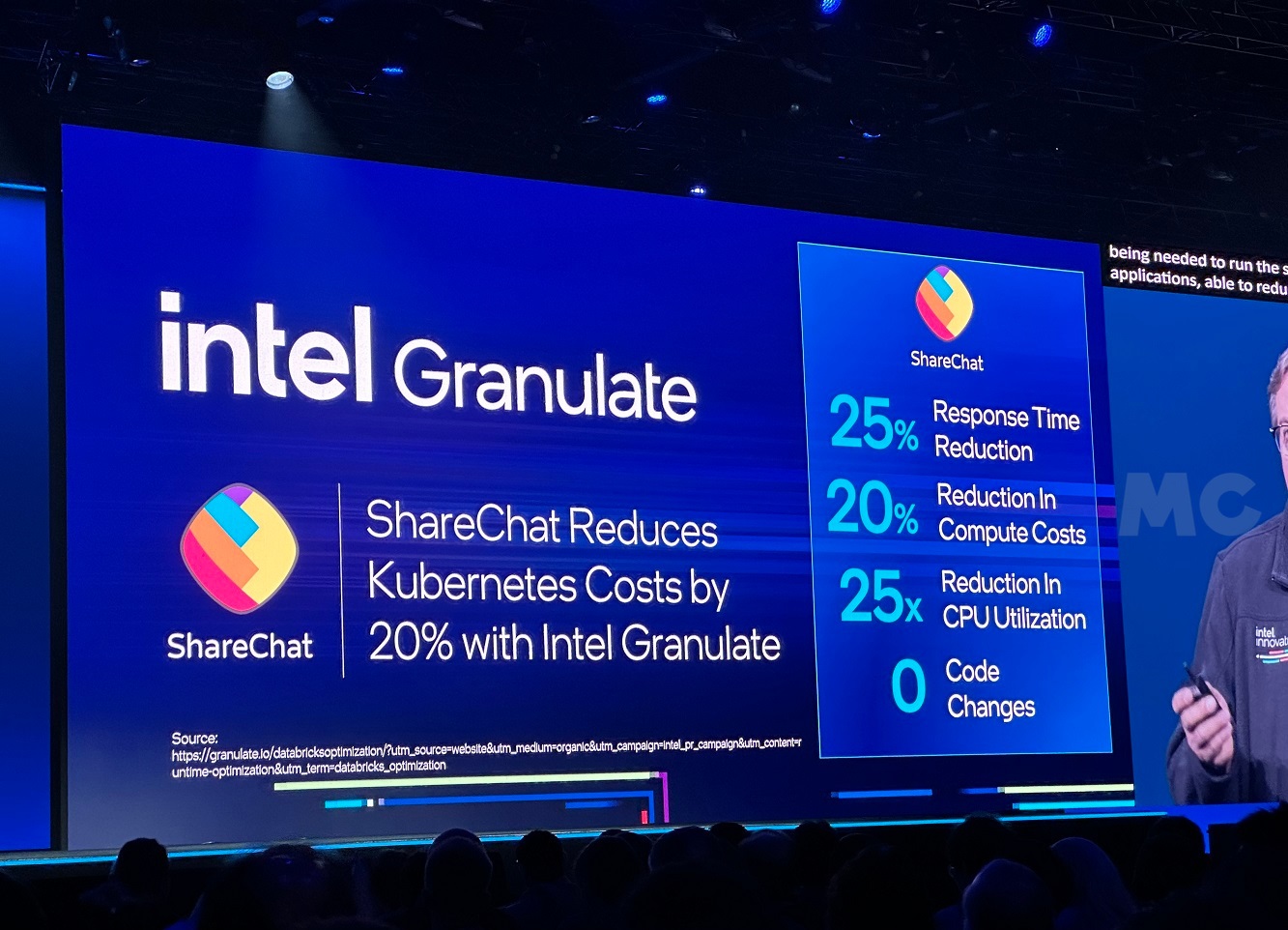

4.-Intel Granulate y la importancia de la optimización

Otra de las cosas que quedó muy clara durante el evento fue que la optimización es fundamental para reducir el consumo de recursos, y que esto a su vez es clave para reducir costes y para democratizar el acceso a la tecnología más avanzada. En este sentido, Intel Granulate juega un rol muy importante porque permite cumplir todos esos objetivos, y ha mejorado notablemente gracias a la integración de Auto Pilot, que lleva a cabo un redimensionamiento para optimizar los recursos del pod de Kubernetes.

Durante la Intel Innovation de 2023 pudimos ver un nuevo ejemplo del valor que ofrece Granulate, en este caso como base de ShareChat, la mayor red social local de la India que cuenta con más de 400 millones de usuarios y que ofrece diferentes opciones para comunicarse, incluyendo las clásicas salas de chat y también las fotografías, los vídeos, los audios, la mensajería directa y los estados. Gracias a Granulate consiguieron:

- Reducir el tiempo de respuesta en un 25%.

- Reducir los costes de computación en un 20%.

- Reducir el uso de CPU en 25 veces, y sin tener que hacer cambios a nivel de código.

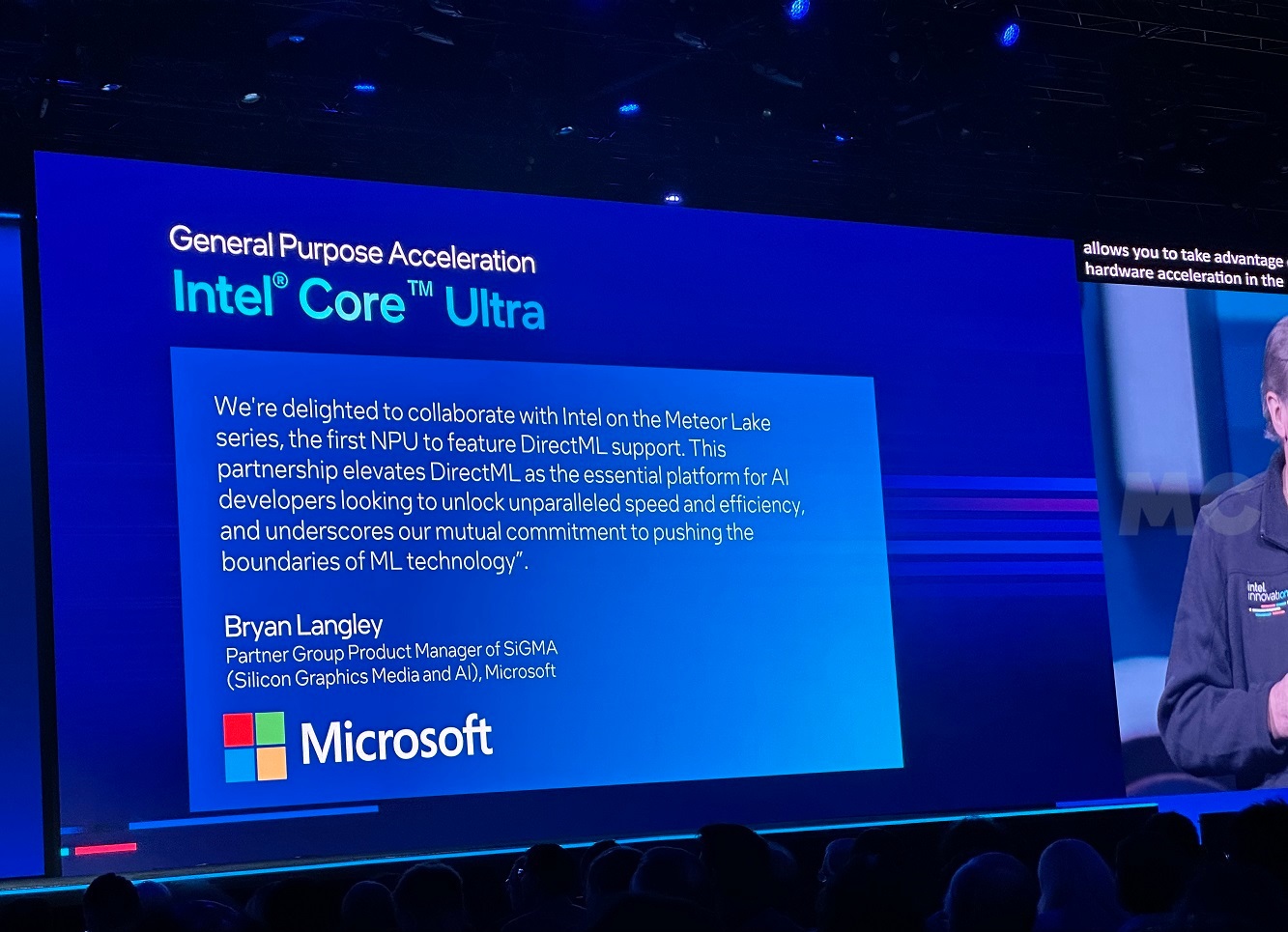

5.-Intel Meteor Lake integra la primera NPU con soporte de DirectML

No es un secreto que Meteor Lake va a representar un salto importante en el mundo de los procesadores de alto rendimiento. De todos sus componentes la NPU que integra es, sin duda, la que ha generado mayor expectación a interés, y es totalmente comprensible ya que se trata de un pequeño «cerebro» que se perfila como la primera de su clase en contar con soporte de DirectML.

Intel confirmó durante el evento que ha colaborado con Microsoft para conseguir un soporte pleno de DirectML en Meteor Lake, una plataforma fundamental para los desarrolladores centrados en la IA que quieran disfrutar de un alto nivel de rendimiento sin tener que renunciar a un elevado nivel de eficiencia. Tanto Intel como Microsoft van a seguir trabajando juntas para impulsar las bondades de DirectML.

Por si alguien se ha perdido, os recuerdo que DirectML es una biblioteca DirectX 12 de bajo nivel acelerada por hardware, la NPU de Meteor Lake en este caso, que soporta también aceleración vía GPU para afrontar tareas de aprendizaje automático que ofrece, además, un alto grado de compatibilidad a nivel de GPU, ya que es compatible con soluciones de Intel, AMD, NVIDIA y Qualcomm. Es ideal para aplicaciones de alto rendimiento y baja latencia en tiempo real, como juegos, por ejemplo, y tiene una interoperabilidad excelente con DirectX3D 12.

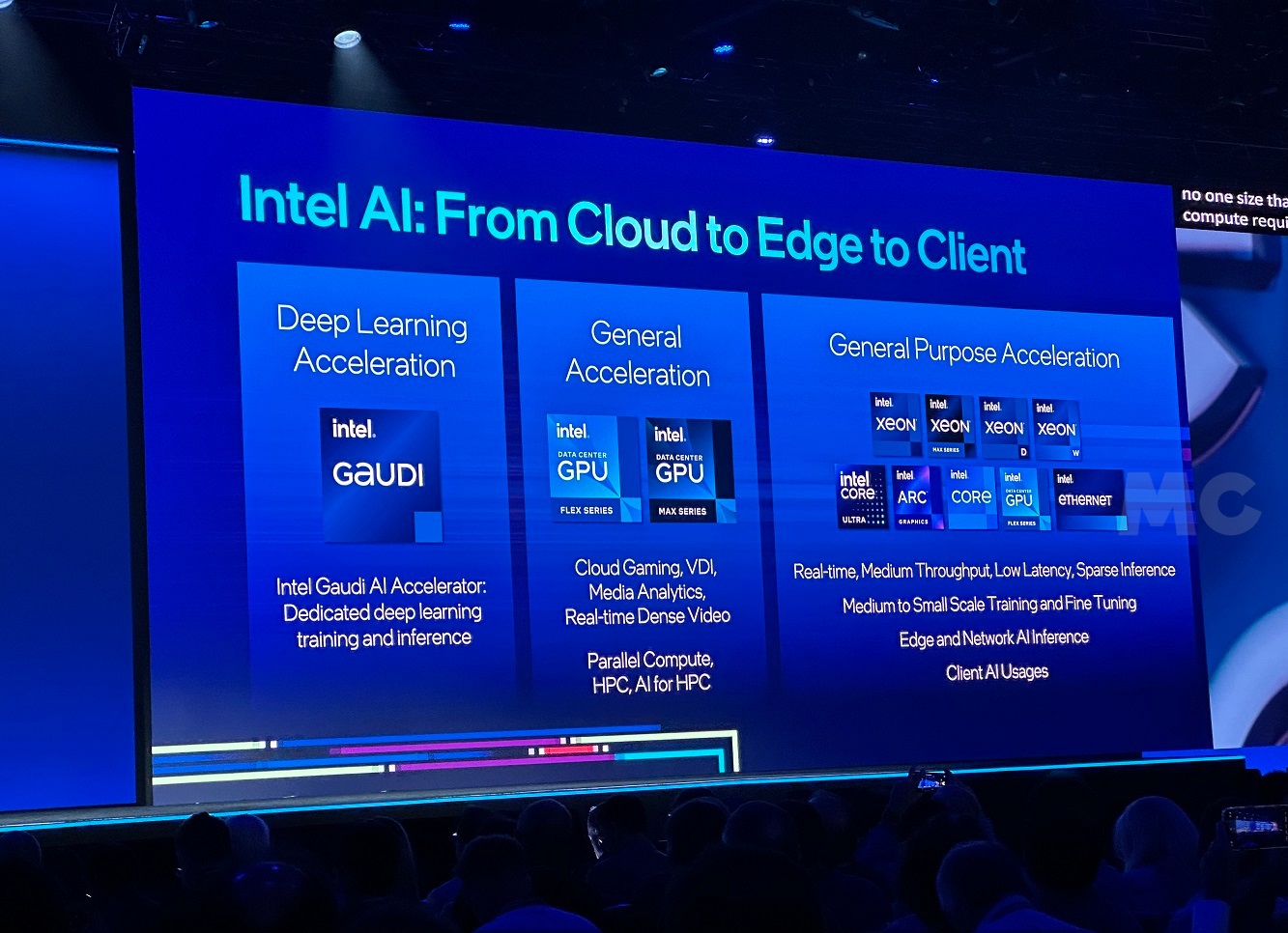

6.-Intel quiere democratizar el acceso a la IA

Y tiene muy claro cómo puede lograrlo. Por un lado tenemos el hardware, donde debemos destacar el amplio abanico de soluciones que ofrece el gigante del chip para cubrir las necesidades de diferentes profesionales y empresas que quieran dar el salto a la IA, pero que tengan presupuestos y objetivos distintos. Con sus soluciones de hardware Intel cubre prácticamente todos los frentes posibles, y ofrece un portafolio impresionante que va desde la nube hasta el borde, y también a la computación cliente (PCs y estaciones de trabajo).

A nivel de software el gigante del chip también está haciendo un gran trabajo apostando por los estándares abiertos, y también por plataformas y herramientas que simplifiquen todo el proceso de desarrollo y que permitan enfoques multiplataforma, reduciendo con ello la carga de trabajo, los costes y acelerando y simplificando los ciclos de trabajo necesarios. En este sentido podemos destacar oneAPI, que permite afrontar con todas las garantías trabajos de desarrollo multiplataforma en diferentes arquitecturas sin ningún tipo de problema.

El compromiso de Intel por un ecosistema abierto que permitan una implementación sencilla y un desarrollo más asequible también es fundamental en este sentido. También hay que destacar la participación de Intel en la Fundación de Aceleración Unificada (UXL) de la Fundación Linux. UXL es, a grandes rasgos, una evolución de la iniciativa oneAPI. Esta última permite al desarrollador escribir el código una vez y despreocuparse por completo, ya que podrá implementarlo sin problemas en diferentes arquitecturas de computación, incluyendo tanto CPUs como GPUs, FPGAs y otros tipos de aceleradoras.

7.-Intel Ignite es más que financiación para las startups, son valores y aprendizaje

El año pasado ya os conté en detalle qué es exactamente Intel Ignite, un programa que elige a las startups más prometedoras y con mayor potencial dentro del sector tecnológico y les proporciona la financiación, los recursos y la ayuda que necesitan para crecer y para desarrollar esa idea que les hizo brilla. Como no podía ser de otra forma este año también quise dedicar una parte de mi tiempo a conocer cómo está evolucionando este proyecto, y la verdad es que quedé gratamente sorprendido.

Durante una mesa redonda tuve la oportunidad de conocer tres grandes proyectos que a día de hoy son de los más importantes dentro de Intel Ignite:

- Themis AI, una extensión del MIT que tiene como objetivo utilizar su tecnología para identificar y mitigar riesgos en modelos de IA de extremo a extremo durante todo su ciclo de vida, lo que permite reforzar la fiabilidad, la solidez y la equidad en los modelos de IA desde su desarrollo hasta su implementación.

- Turin Tech, una startup de optimización de código que utiliza IA y que se centra en cargas de datos muy pesadas. Sus herramientas de optimización son de las más avanzadas y efectivas del mercado, tanto que ya han ayudado a miles de desarrolladores a optimizar y mejorar tanto la calidad como la eficiencia de su código.

- MinIO, esta empresa fue fundada en 2014 para responder a las necesidades y a los desafíos que presentaba el crecimiento desestructurado de datos. Fue pionera en la creación de soluciones nativas de alto rendimiento de almacenamiento de objetos en Kubernetes.

A través de Intel Ignite esos tres proyectos consiguieron todo el apoyo que necesitaron, pero el valor de este programa va más allá del tema económico. Durante la mesa redonda pude preguntar a Anand Babu Periasamy, CEO de MinIO, cuáles fueron las lecciones más valiosas que aprendió durante su colaboración con Intel, y su respuesta fue tan clara como interesante, ya que la describió como un proceso de aprendizaje lleno de valores, entre los que destacó la importancia que tienen la imagen y el nombre de una empresa, en referencia a cómo ambas deben inspirar confianza entre los consumidores y generar interés en ellos.

8.-La importancia del ecosistema y de las soluciones especializadas al extremo

Intel puede presumir de tener en su haber un conjunto muy amplio de soluciones tanto a nivel de software como de hardware. En este punto quiero centrarme un poco más en las soluciones de hardware porque estas fueron, sin duda, uno de los grandes protagonistas del evento. Actualmente el gigante del chip ofrece diferentes soluciones tanto en el mercado CPU como en el sector GPU, y también tiene una gran variedad de aceleradores y de soluciones especializadas.

Esto le permite cubrir prácticamente la totalidad del sector tecnológico y llegar a perfiles de usuario muy diferentes. Sin embargo, Intel no se ha limitado a adoptar una categorización siguiendo el concepto de distintos productos para distintas necesidades, también ha apostado por la especialización para cubrir esas necesidades de una manera más precisa y eficiente. En este sentido podemos destacar las distintas líneas de producto que ha integrado en un mismo mercado.

Así, por ejemplo, tenemos los procesadores Sapphire Rapids, que están centrados en ofrecer el máximo rendimiento por núcleo y que utilizan además aceleradores específicos para afrontar tareas concretas con todas las garantías, y también tenemos los procesadores Sierra Forest, que parten de un enfoque distinto y se centran en maximizar la capacidad de paralelización y la eficiencia. Los primeros tienen hasta 60 núcleos Golden Cove, y los segundos hasta 144 núcleos Gracemont, lo que significa que podemos llegar a 288 núcleos con una configuración de doble socket.

9.-Meteor Lake es una auténtica revolución que va más allá de la potencia bruta

Intel Meteor Lake no será un procesador más, será un chip que marcará el inicio de la era de la IA en el mundo del PC de consumo general. Esto lo convierte en un auténtico pionero, y abrirá las puertas a nuevas posibilidades y nuevas experiencias que no harán más que mejorar y evolucionar con el paso del tiempo. Solo por esto ya merece ser considerado como una revolución dentro del sector de los procesadores de consumo general, para portátiles, pero esto es solo la punta del iceberg.

Los nuevos procesadores Meteor Lake son los primeros en utilizar el nodo Intel 4, uno de los más avanzados que existen a día de hoy. Esto permite reducir el tamaño de los transistores y aumentar la densidad de estos, y también abre las puertas a un aumento del rendimiento y a una mejora de la eficiencia. A nivel de diseño y de integración del silicio también son revolucionarios, ya que están divididos en tres grandes bloques o «tiles», uno para la CPU, otro para la GPU y otro conocido como SoC, que integra el subsistema I/O, la NPU y otros elementos.

Intel ha utilizado litografía ultravioleta extrema para fabricar los Meteor Lake, y ha recurrido a una arquitectura 3D híbrida y al empaquetado Foveros 3D. ¿Impresionado? Pues espera, que la cosa no termina aquí, estos procesadores estrenan dos nuevas arquitecturas, Redwood Cove en sus núcleos de alto rendimiento y Crestmont en sus núcleos de alta eficiencia, lo que significa que podemos esperar mejoras a nivel de IPC en ambos bloques de núcleos.

También utilizarán GPUs Intel Arc más potentes, soportarán los últimos estándares multimedia y de salida de imagen, darán soporte del nuevo estándar Wi-Fi 7, contarán con dos nuevos núcleos de consumo ultra bajo integrados en el bloque SoC y vendrán con una NPU que permitirá acelerar cargas de trabajo asociadas a la IA a nivel local. Esto va a representar un avance muy importante, ya que nos dará la posibilidad de disfrutar de funciones avanzadas potenciadas por IA en local. Windows Copilot es, sin duda, el mejor ejemplo.

10.-Cinco nodos de proceso en cuatro años

Uno de los grandes objetivos que se marcó Intel tras la llegada de Pat Gelsinger al puesto de CEO fue precisamente este, desarrollar y fabricar un total de cinco nodos en un máximo de cuatro años. Es un objetivo muy importante, porque para el gigante del chip es fundamental recuperar el liderazgo en el sector de la fabricación de semiconductores, pero hay que reconocer que también es muy complicado porque, al final, Intel siempre acaba adoptando diseños con una mayor densidad de transistores.

Con Alder Lake se produjo el debut del nodo Intel 7, y con Meteor Lake se estrenará el nodo Intel 4. El gigante del chip nos confirmó hace un par de días que el nodo Intel 4 ya ha entrado en fase de fabricación en masa, lo que significa que no habrá retrasos y que su lanzamiento tendrá lugar el 14 de diciembre de este mismo año. Su siguiente objetivo será el nodo Intel 3, y posteriormente llegará el nodo Intel 20A.

El nodo Intel 18A será el último dentro de ese plan de cinco nodos en cuatro años. Ya está en desarrollo, utilizará la litografía ultravioleta extrema «High-NA», transistores RibbonFET y alimentación PowerVia, y se espera que las primeras unidades se empiecen a fabricar en el primer trimestre de 2024. Es importante que tengáis en cuenta que hablamos de unidades en fase de prueba, y que por tanto todavía tendrá que pasar un tiempo hasta que esta arquitectura pase a la etapa de fabricación en masa.

11.-Vida más allá de la computación tradicional: computación cuántica, computación neuromórfica y fotónica

Nos encontramos en una etapa que, desde luego, es un auténtico privilegio para los amantes de la tecnología en general. La computación tradicional basada en silicio lleva un tiempo coexistiendo con la computación neuromórfica, con la computación cuántica y también con la fotónica, tres grandes claves que también se han convertido en objetivos importantes para Intel y que, como sabrán muchos de nuestros lectores, están siendo impulsados por Intel Labs.

La fotónica integrada es clave porque nos permitirá dar un gran salto en términos de ancho de banda en las comunicaciones silicio/servidor y redes, y superar las limitaciones de las interconexiones eléctricas, mejorando además la eficiencia y reduciendo los costes. Intel Labs ha logrado importantes avances en este campo, y entre ellos podemos destacar el desarrollo de una nueva matriz de rayos láser de retroalimentación distribuida de ocho longitudes de onda, que se puede trasladar a la oblea utilizando el nodo de fabricación de fotónica de silicio de 300 mm de Intel.

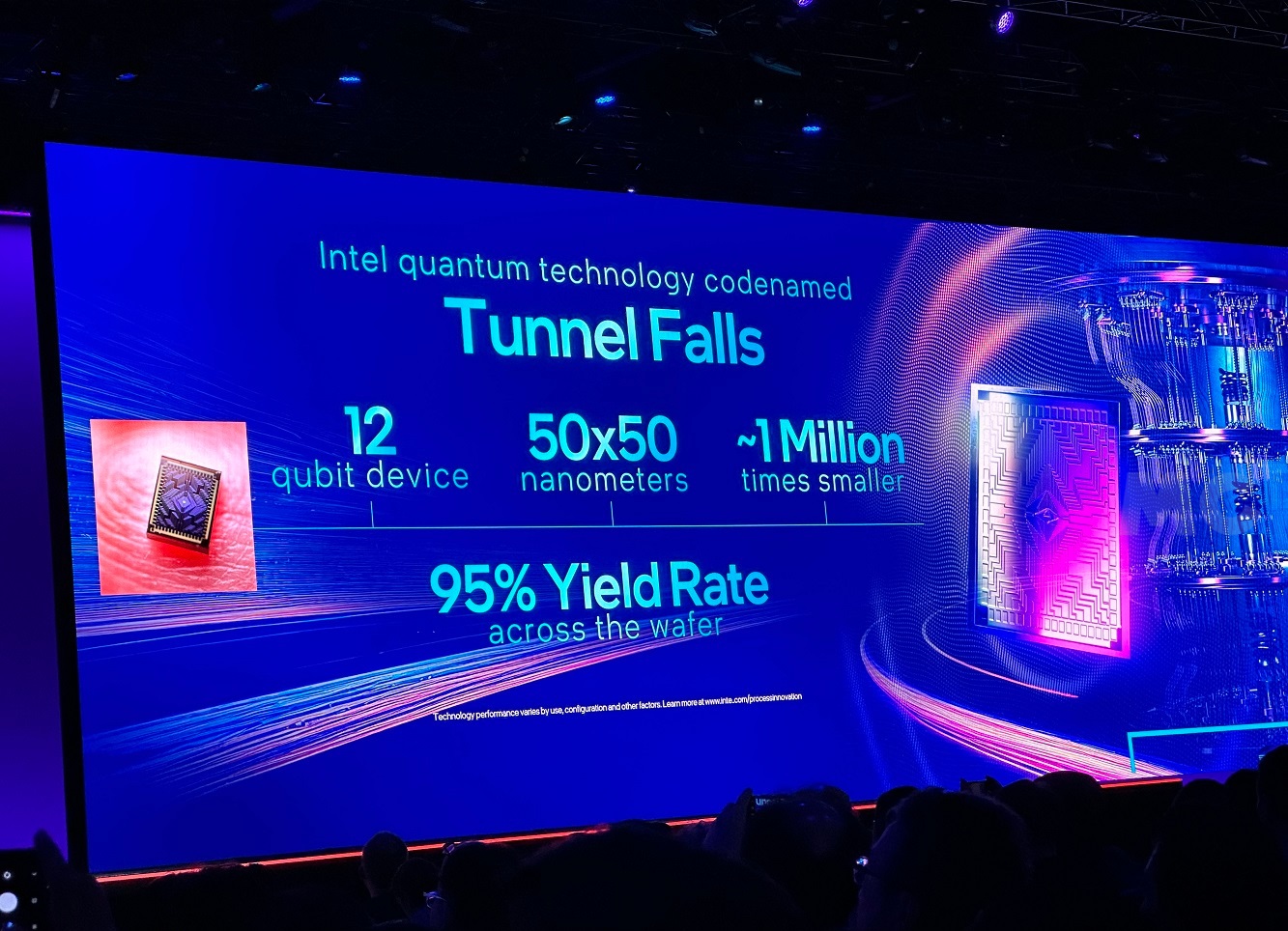

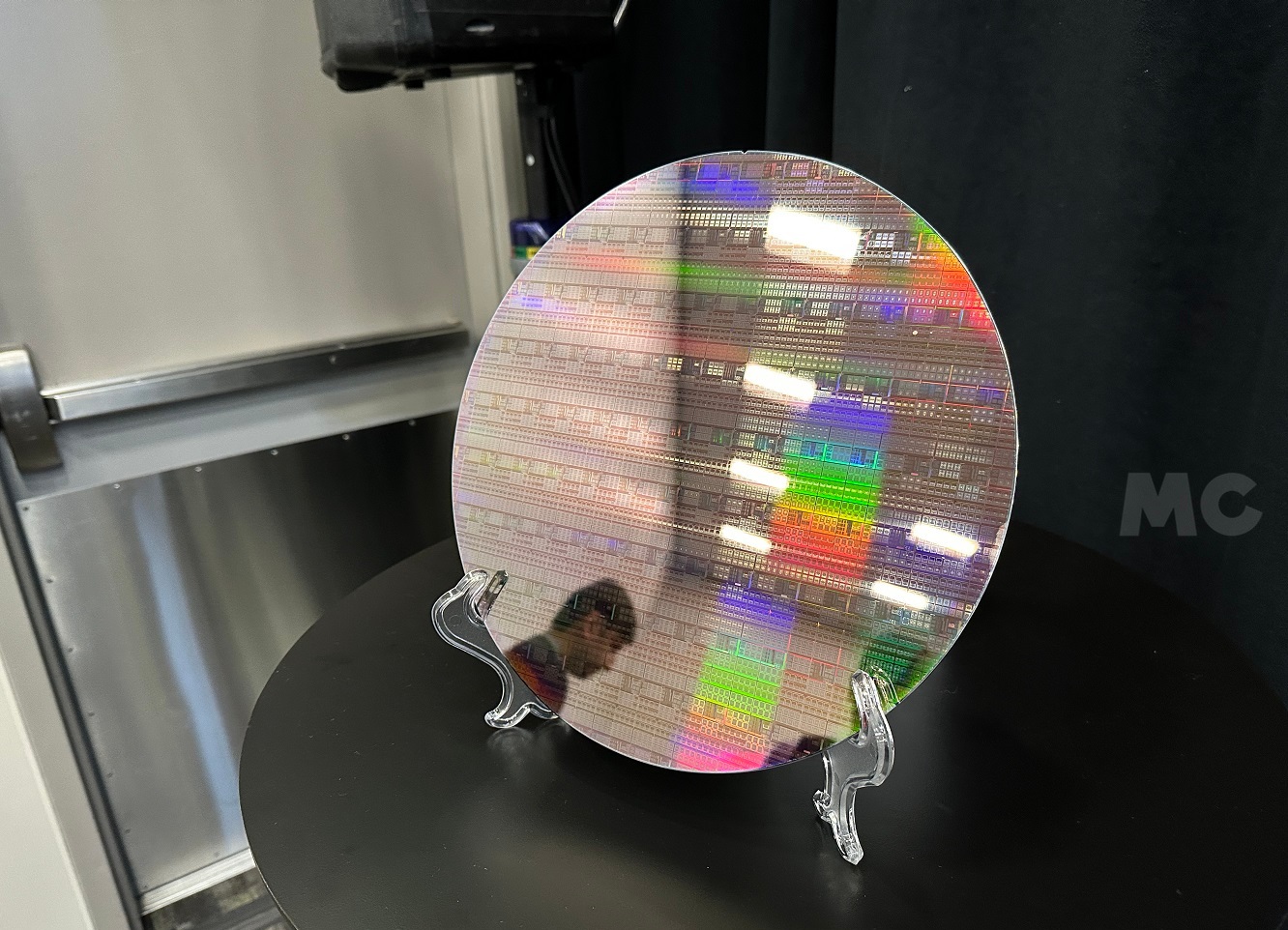

Tunnel Falls fue otro de los avances más importantes que consiguió Intel en el mundo de la computación cuántica, un chip de silicio de 12 qubits que marcó un importante punto de inflexión y que tuve la oportunidad de ver más de cerca en una oblea durante una de las mesas redondas a las que asistí. Os dejo una foto para que disfrutéis también de esas vistas únicas.

La computación cuántica abre nuevos horizontes y nos permite afrontar retos que serían imposibles con la computación tradicional, pero no debemos olvidarnos de la computación neuromórfica, que tiene también tiene un papel muy importante, ya que nos permite utilizar chips que trabajan de una manera similar a como lo hace el cerebro humano para adoptar nuevos modelos de aprendizaje profundo partiendo de redes neuronales.

12.-Silicio en 2.5D y silicio en 3D

La integración de diferentes chiplets dentro de un empaquetado puede llevarse a cabo de diferentes maneras. A día de hoy la más común es la distribución en 2.5D, que básicamente coloca diferentes chiplets en horizontal y los interconecta utilizando una tecnología concreta para que puedan comunicarse de forma óptima. Intel ha sido una de las que ha venido utilizando este modelo, pero tiene claro que el futuro está en el silicio apilado en 3D.

El apilado en 3D consiste en colocar chips de silicio encima de otros chips de silicio, lo que se traduce en una distribución en vertical. Estos se comunican a través de sistemas de interconexión a través del silicio. Gracias a este método de apilado será posible crear soluciones más potentes y más completas con las que responder a las necesidades de cada sector de una manera más eficiente.

Intel mostró un diagrama que pudimos ver de una manera muy clara el potencial que tiene el apilado 3D, y que podéis encontrar en la imagen adjunta. Gracias a esta tecnología será posible integrar una enorme cantidad de elementos en un único empaquetado, y crear soluciones con un nivel de potencia y de prestaciones que directamente sería inviable bajo el clásico modelo 2.5D.

Sobre este tema quiero destacar algo importante, y es que el propio CEO de Intel, Pat Gelsinger, comentó que no descartan utilizar el apilado 3D para crear procesadores de alto rendimiento con grandes cantidades de caché. Esto abriría las puertas a la creación de nuevas CPUs especializadas en juegos, por ejemplo, que son las aplicaciones que más se benefician de una mayor cantidad de caché L3.

13.-Especialización a través de núcleos P y núcleos E

Alder Lake marcó el estreno de la división entre núcleos P y núcleos E. Gracias a esa división en dos bloques de núcleos Intel pudo aprovechar mejor el espacio libre a nivel de silicio, mejoró la capacidad de paralelizado de sus procesadores al aumentar el máximo de núcleos, y al mismo tiempo dio un salto importante a nivel de eficiencia gracias a una distribución inteligente de las cargas de trabajo entre ambos bloques de núcleos.

No hay duda de que fue todo un éxito, pero Intel ha sabido ir más allá y ha aprovechado el potencial que ofrecen ambos tipos de núcleos para crear soluciones especializadas. Estoy hablando de Sapphire Rapids, que solo utiliza núcleos P, y de Sierra Forest, que solo utiliza núcleos E.

Creo que sería muy interesante que Intel trasladase esta estrategia también al mercado de consumo general, y que diese forma a procesadores equipados únicamente con núcleos P. La compañía podría aprovechar el espacio a nivel de silicio que quedaría libre al suprimir los bloques de núcleos E para integrar una mayor cantidad de caché L3, por ejemplo.

14.-Meteor Lake es solo el principio de la IA en el mercado de consumo

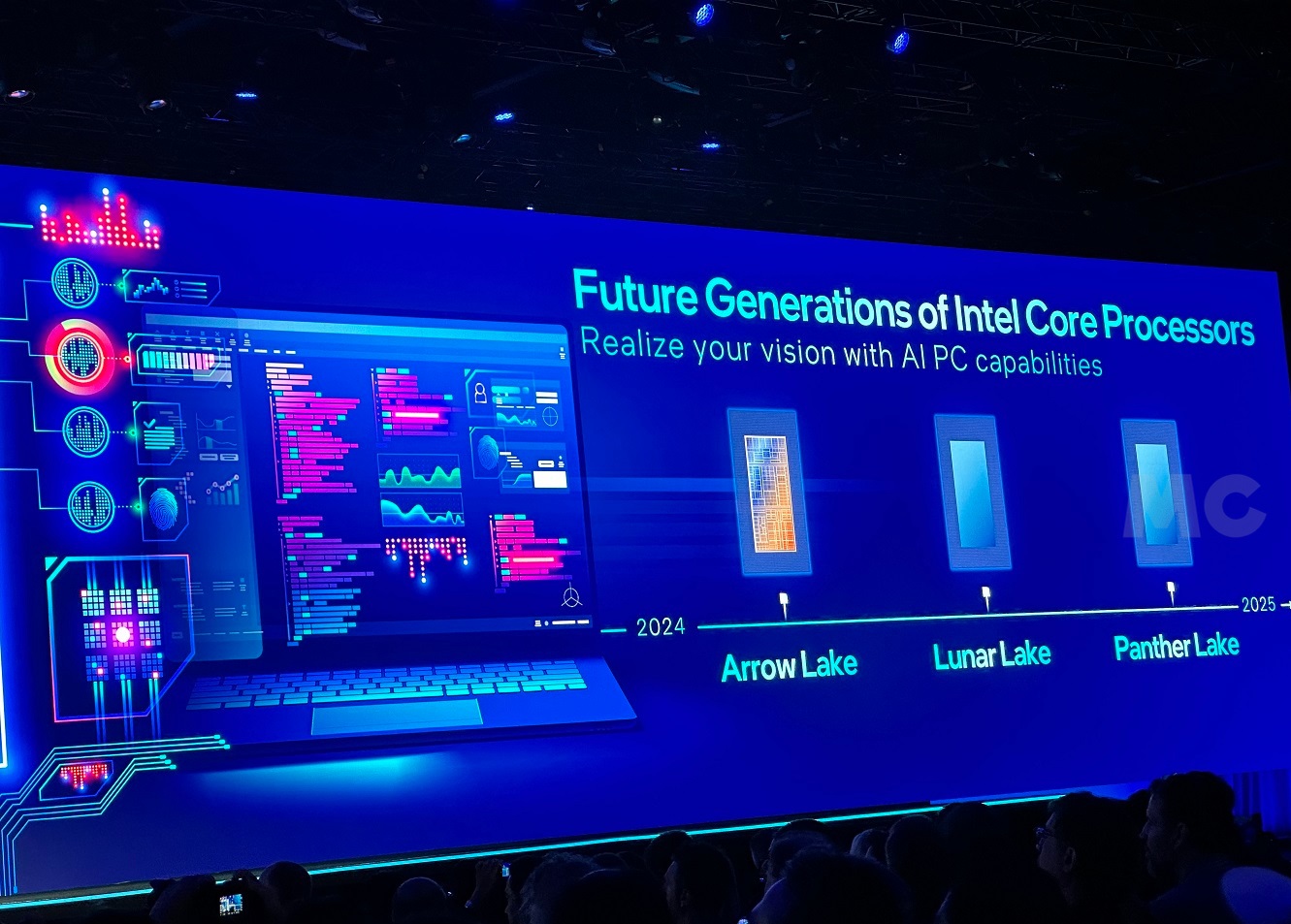

Esto es algo que ya sabíamos, pero si por si quedaba alguna duda Intel confirmó que tendrá como sucesores a Arrow Lake, Lunar Lake y Panther Lake, y de hecho se atrevió a realizar una demostración en el escenario utilizando una muestra de ingeniería de Lunar Lake, un procesador de próxima generación que llegará al mercado en algún momento de 2025.

La demo que mostró Intel se centró en las capacidades de IA generativa que ofrecerá la NPU de tercera generación que traerá Lunar Lake, utilizando para ello una herramienta similar a Stable Diffusion ejecutada completamente en local, es decir, que funcionaba únicamente sobre el procesador Lunar Lake y su unidad de procesamiento neural, y que no contaba con ningún otro tipo de apoyo externo.

Lunar Lake fue capaz de generar la imagen de una jirafa con un sombrero e incluso de escribir la letra de una canción desde cero, todo en un tiempo sorprendentemente reducido, tanto que se colocó al nivel propio de servicios de IA dedicados en la nube, y de aceleradores de IA independientes. Creo que esto dice mucho de lo que podemos esperar de las NPU de Intel, y de lo que está por venir.

15.-Intel lo tiene claro, la IA nos hará la vida más fácil

Y en sentido amplio. Gracias a la inteligencia artificial podremos disfrutar de funciones y herramientas que hasta hace unos años solo nos habríamos atrevido a soñar. La IA generativa es sin duda uno de los avances más prometedores, pero no debemos olvidarnos de otras implementaciones muy interesantes y muy importantes.

Podría poneros muchos ejemplos, pero entre los más atractivos se encuentran sin duda la creación de sistemas operativos inteligentes que mejoren la experiencia de uso, las herramientas potenciadas por IA que nos ayuden a ser más productivos, los asistentes interactivos de última generación con capacidades de interacción superior a los modelos actuales y otros tipos de aplicaciones que utilizarán la IA para crear y ofrecer una experiencia de uso mejorada y realmente única.

Microsoft Copilot es ahora mismo el mejor ejemplo de lo que podemos esperar de esta primera etapa de la IA aplicada al mundo del PC. Gracias a esta actualización la IA llega a Windows 11, y nos permite disfrutar de nuevas funciones y características que automatizan una gran cantidad de tareas que antes podían llevarnos mucho tiempo. La NPU de los procesadores Meteor Lake asumirá la carga de trabajo que representa la adopción de la IA, liberando por completo al procesador y a la GPU.

-

GuíasHace 3 días

GuíasHace 3 díasDisplayPort o HDMI, ¿Qué interfaz conviene usar en cada tarea informática?

-

AnálisisHace 2 días

AnálisisHace 2 díasRobot aspirador Eureka J12 Ultra, análisis: rapidez a gran escala

-

NoticiasHace 2 días

NoticiasHace 2 díasComprar una SSD será cada vez más caro

-

NoticiasHace 2 días

NoticiasHace 2 díasBitLocker en Windows, ¿activación automática en próximas versiones?