Noticias

Computación cuántica y ruido, ¿cuándo llegaremos a la practicidad cuántica?

La computación cuántica se ha convertido en el Santo Grial de la computación, aunque desde hace tiempo ha dejado de ser el futuro para convertirse, cada vez más, en el presente. Es cierto que todavía faltan muchos años hasta que lleguemos a ese punto en el que la computación tradicional empezará a ser desplazada por la computación cuántica, pero es imposible negar que ya estamos recorriendo ese camino, y que no hay retorno.

En líneas generales, la computación cuántica me recuerda mucho a esa transición casi «mágica» que supuso el salto de lo analógico, de la computación basada en relés y válvulas de vacío, a la era de los transistores, aunque este nuevo tipo de computación no está destinada a sustituir plenamente a la actual, y no hay duda de que acabará representando una evolución aún mayor, y mucho más impresionante.

Como dije, hemos avanzado mucho, pero todavía nos quedan muchos pasos importantes que dar y muchas cuestiones, y desafíos, que resolver. En este sentido Norberto Mateos Carrascal, Country Manager de Intel España, nos ha enviado un interesante artículo de opinión donde explica algunos de los puntos más importantes de la computación cuántica, y queremos compartirlo con vosotros porque estamos convencidos de que os ayudará a profundizar y a entender mejor todas las claves que rodean a la computación cuántica.

Superordenadores y computación cuántica: ¿cuál es la diferencia?

Los ordenadores cuánticos llevan décadas gestándose. Considerados como la próxima gran novedad con el potencial de resolver muchos de los problemas actuales, se espera que el mercado de la computación cuántica alcance los 1.760 millones de dólares en 2026, impulsado por las inversiones del sector público en investigación y desarrollo, según MarketsandMarkets Research Private Ltd.

La mayoría de los usuarios piensan en la potencia de cálculo en términos de la velocidad de un ordenador. Para las cargas de trabajo comerciales que manejan cálculos masivos y bases de datos, como la previsión meteorológica y el modelado molecular, incluso los mejores ordenadores de sobremesa de consumo son inadecuados. Aquí es donde entran en juego los superordenadores. Como todos los ordenadores clásicos, funcionan basándose en el cálculo de datos binarios: uno o cero. Sí o no. Encendido o apagado. La complejidad viene cuando se presentan largas cadenas de información binaria.

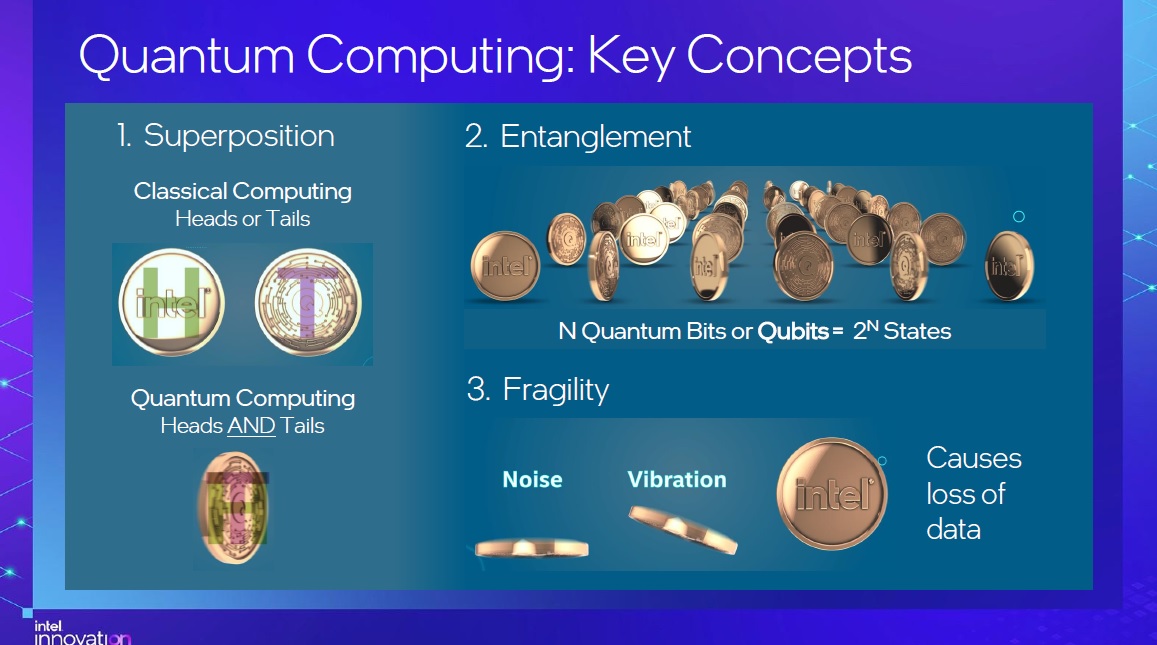

En comparación, los ordenadores cuánticos funcionan según los principios de la física cuántica y, por tanto, se basan en bits cuánticos o qubits. Una forma sencilla de entender un qubit es pensar en él como una moneda, que tiene dos lados: cara o de cruz. Imaginemos que la moneda está girando y, mientras lo hace, se encuentra en cierto modo en los estados de cara y cruz al mismo tiempo. Este estado se conoce como «superposición» de los dos estados. Con dos de estas monedas giratorias, tendremos cuatro estados al mismo tiempo. Por tanto, la potencia de un ordenador cuántico crece exponencialmente con el número de qubits. En teoría, con 50 de estos qubits entrelazados, podríamos acceder a más estados que un superordenador. Con 300 qubits entrelazados, representaría más estados que los átomos del universo al mismo tiempo.

A diferencia de los superordenadores, los ordenadores cuánticos tratan los datos de forma no binaria y realizan cálculos basados en probabilidades. Los usos prácticos de un ordenador cuántico están aún por descubrir, pero la probabilidad de que rompan los algoritmos de encriptación más potentes disponibles en la actualidad hace que los gobiernos y las organizaciones se planteen el potencial de estos sistemas. Por ejemplo, un ordenador convencional tardaría unos 300 billones de años en romper el algoritmo de cifrado de 2.048 bits de RSA. En cambio, un ordenador cuántico de 4.099 qubits sólo necesita 10 segundos.

En noviembre de 2021, se produjo el mayor el hito alcanzado en materia de ordenadores cuánticos, que es de sólo 127 qubits, por lo que aún estamos muy lejos de un ordenador cuántico de 4.099 qubits.

El largo camino hacia la practicidad cuántica

En realidad, necesitamos más de un millón de qubits de alta calidad para comercializar la computación cuántica, lo que se conoce como alcanzar la «practicidad cuántica». o lo que es lo mismo, cuando un ordenador cuántico ha alcanzado la viabilidad comercial y puede resolver problemas relevantes del mundo real.

El reto por tanto está en la fragilidad de los qubits, que tienen una vida muy corta (microsegundos), y el más mínimo «ruido», como las interferencias externas de los campos magnéticos y la variación de la temperatura, puede provocar la pérdida de información. He aquí tres áreas clave que debemos abordar para avanzar en la escalabilidad de sistemas de computación cuántica viables.

Gestión de qubits a alta temperatura con qubits de espín

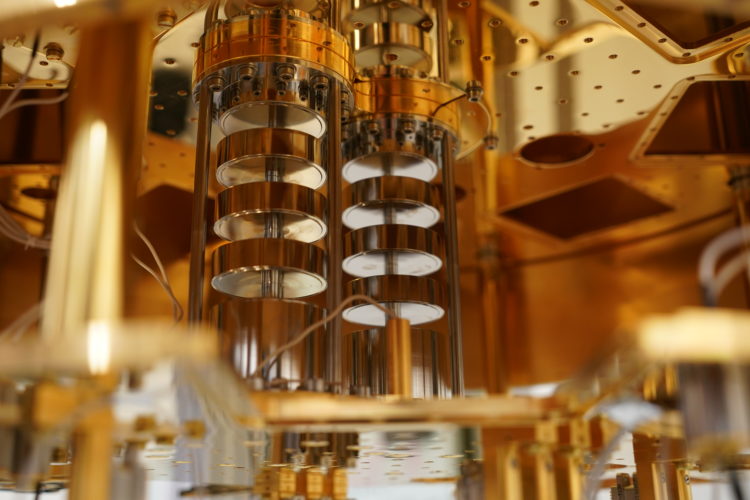

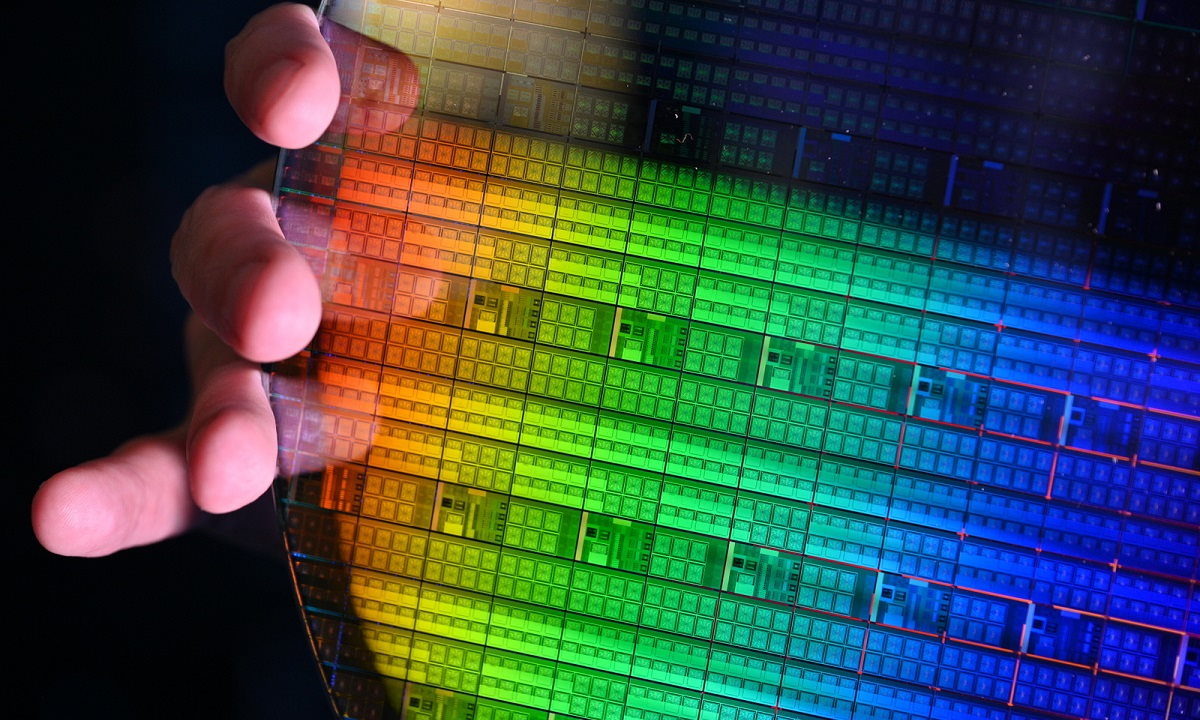

La naturaleza frágil de los qubits requiere que funcionen a una temperatura extremadamente fría (20 milikelvin, o unos -273 grados centígrados), lo que también supone un reto para el diseño de los materiales de los propios chips y la electrónica de control necesaria para hacerlos funcionar. En su empeño por escalar los chips cuánticos, Intel, en colaboración con QuTech, produjo un proceso tecnológico de qubits de espín de silicio que permitió fabricar más de 10.000 matrices con varios qubits en una sola oblea con un rendimiento superior al 95%. Los qubits de espín son muy similares a los transistores y se fabrican con tecnología de proceso de 300 mm en las mismas fábricas que los chips de semiconductores de óxido metálico complementarios (CMOS, por sus siglas en inglés) de Intel. La investigación conjunta demostró que es posible que los qubits se produzcan junto a los chips convencionales en las mismas instalaciones de fabricación.

Estos qubits de espín son mucho más pequeños, pero tienen un tiempo de coherencia más largo y pueden funcionar a temperaturas más altas que los qubits superconductores (1 kelvin/-272,15 grados Celsius), una ventaja para la escalabilidad. Estas características reducen drásticamente la complejidad del sistema necesario para el funcionamiento de los chips al permitir la integración de la electrónica de control mucho más cerca del procesador. La investigación también destaca el control coherente individual de dos qubits con fidelidades de un solo qubit de hasta el 99,3 por ciento. Estos avances señalan la posibilidad de que los controles criogénicos de un futuro sistema cuántico y los qubits de espín de silicio se unan en un paquete integrado.

Simplificación del diseño del sistema para acelerar el tiempo de preparación y mejorar el rendimiento de los qubits

Otro reto clave en los sistemas cuánticos actuales es el uso de electrónica a temperatura ambiente y los numerosos cables coaxiales que se dirigen al chip qubit dentro de un refrigerador de dilución. Este enfoque no se adapta a un gran número de qubits debido al factor de forma, el coste, el consumo de energía y la carga térmica del refrigerador. Es crucial abordar este reto y simplificar radicalmente la necesidad de múltiples bastidores de equipos y miles de cables que entran y salen del frigorífico para hacer funcionar una máquina cuántica.

Intel ha sustituido estos instrumentos de gran tamaño por un sistema en un chip (SoC, por sus siglas en inglés) altamente integrado y el primer chip de control de computación cuántica criogénica que simplifica el diseño del sistema. Este enfoque utiliza sofisticadas técnicas de procesamiento de señales para acelerar el tiempo de configuración, mejorar el rendimiento de los qubits y permitir a los equipos de ingeniería escalar eficazmente el sistema cuántico a un mayor número de qubits.

Un enfoque escalable de la computación cuántica

Dado que la computación cuántica es un tipo de computación completamente nueva, tiene una forma totalmente diferente de ejecutar programas que requieren un nuevo hardware, software y aplicaciones desarrollados específicamente para estos sistemas. Esto significa que los ordenadores cuánticos necesitan componentes nuevos en todos los niveles, desde el procesador de control de qubits, la electrónica de control, hasta el dispositivo de chip de qubits, entre otros. Intel está trabajando intensamente en el desarrollo de todos estos componentes para la pila completa. El reto consiste en conseguir que todos esos componentes funcionen juntos, que es como coreografiar una danza cuántica.

Está claro que los ordenadores cuánticos no están destinados a sustituir la infraestructura informática clásica, si no que están pensados para aumentarla. Su desarrollo tiene como objetivo resolver algunos de los retos más intrincados del mundo que han dejado sin respuesta a los ordenadores clásicos actuales. Pero el camino hacia la construcción de un sistema viable que funcione a nivel práctico y comercial requerirá persistencia, paciencia y partnerships estratégicos.

En cierto modo, en Intel, nuestro trabajo en los ordenadores clásicos nos hace especialmente aptos para esta tarea, dada la escala que se necesita para abordar los principales retos a los que se enfrenta el desarrollo de la informática cuántica. Los avances que hemos hecho con la tecnología de qubits de espín, el control criogénico y el desarrollo de una pila tecnológica completa son sólo algunas de las cosas en las que Intel está avanzando para que la computación cuántica sea totalmente viable y práctica en un futuro no muy lejano.

-

A FondoHace 5 días

A FondoHace 5 díasCinco lecciones que podemos extraer del incidente de CrowdStrike

-

NoticiasHace 5 días

NoticiasHace 5 díasMicrosoft publica una herramienta gratuita para solucionar el error CrowdStrike

-

NoticiasHace 5 días

NoticiasHace 5 díasLa inversión en TI a nivel mundial crecerá un 7,5% en 2024

-

NoticiasHace 4 días

NoticiasHace 4 díasKamala Harris: una posible presidencia de más regulación tecnológica