Noticias

Microsoft invirtió cientos de millones en el desarrollo de un ordenador para ChatGPT

Hace ya unos años, en 2019, Microsoft anunció que iba a invertir 1.000 millones de dólares en OpenAI. Entonces accedió a desarrollar un superordenador de última generación para la compañía de investigación en Inteligencia Artificial. El único problema era que Microsoft no tenía ningún sistema como los que necesitaba OpenAI, y sus directivos no estaban totalmente seguros de poder desarrollar algo tan grande como lo que necesitaban en su servicio cloud Azure sin provocar su fallo y caída.

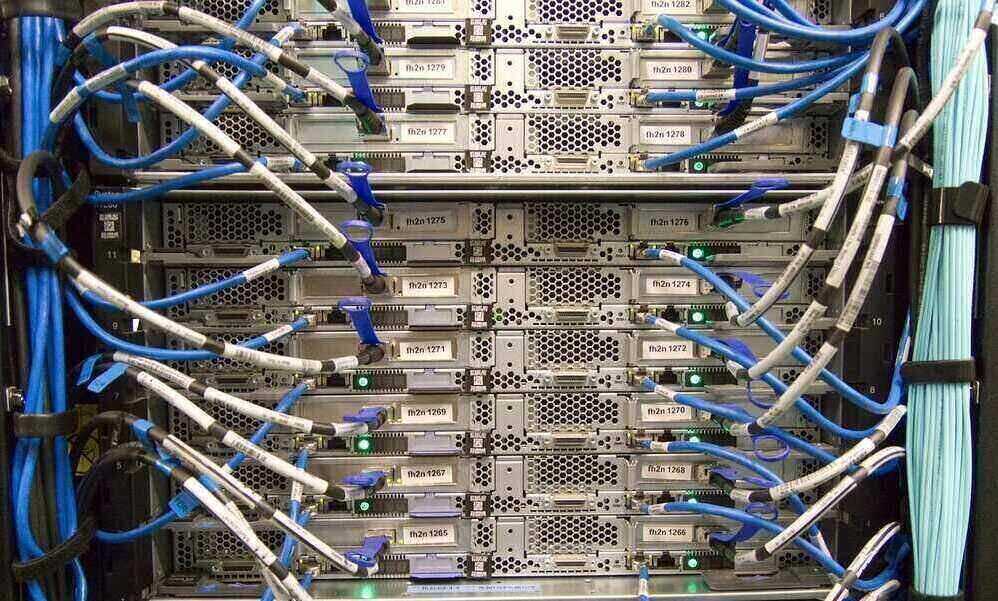

OpenAI estaba intentando entrenar diversos modelos de Inteligencia Artificial, que cada vez consumían más cantidad de datos y aprendían más parámetros. Por eso necesitaba acceso a servicios de computación en la nube muy potentes, y durante periodos prolongados de tiempo. Esto llevó, según Bloomberg, a que los de Redmond tuviesen que desarrollar un superordenador con la potencia y componentes necesarios para poder impulsar el desarrollo y funcionamiento de, entre otros, ChatGPT.

Entre otras cosas, para conseguirlo tuvieron que dar con la clave para interconectar varias decenas de miles de tarjetas gráficas A100 de Nvidia, lo que dio al sistema la potencia de proceso necesaria para el desarrollo del chatbot. Pero para poder hacerlo tuvieron incluso que cambiar cómo colocaban los servidores en los racks, de manera que no sufriesen cortes de energía.

Según Nidhi Chappel, Responsable de la infraestructura de Azure AI, gracias a que fueron capaces de construir la arquitectura de un sistema que podía operar y ser fiable a una escala muy elevada, pudieron desarrollar ChatGPT. Pero este es solo el principio, y del proyecto que ha llevado a su desarrollo van a salir muchos modelos nuevos de IA más.

Por su parte, Scott Guthrie, Vicepresidente de Microsoft y Responsable de cloud e Inteligencia Artificial de Microsoft, señala que aunque ChatGPT es, de hecho, el caso de uso más popular presentado hasta ahora de este superordenador que construyeron, este se puede adaptar a diversos casos de uso. Por tanto, no se trata de un desarrollo a medida, sino de uno pensado para hacer avanzar los desarrollos de Inteligencia Artificial de Microsoft y OpenAI en general.

Así, el directivo recalca que no construyeron un equipo personalizado, y que aunque comenzó siendo así, evolucionó hasta un sistema de propósito general, porque los desarrollaron de manera que «si alguien quiere entrenar un modelo de lenguaje de gran envergadura, pueda aprovechar las mismas mejoras. Esto nos ha ayudado mucho a convertirnos en una nube mejor para la Inteligencia Artificial en general«.

Además, Guthrie ha recordado que el modelo con el que todos están trabajando y ensayando ahora ha sido posible gracias a un superordenador que ya tiene un par de años de antigüedad. De hecho, el equipo ya está entrenando a su superordenador de próxima generación, que según el directivo es «mucho mayor, y permitirá conseguir todavía más sofisticación«.

Entrenar un modelo de IA a gran escala necesita gran cantidad de unidades de proceso gráfico interconectadas en un punto, como Microsoft hizo con el sistema desarrollado para el superordenador que trabaja con la IA. Pero una vez que un modelo se utiliza, responder a todas las preguntas que hacen los usuarios, a lo que se conoce como inferencia, requiere una configuración distinta.

Microsoft también despliega chips gráficos para inferencia. Eso sí, estos cientos de miles de procesadores están repartidos por las más de 60 regiones de centros de datos que tiene la compañía, que ahora está agregando los últimos chips gráficos de Nvidia, los H100, a sus sistemas para trabajar con cargas de IA. También ha agregado a estos sistemas la nueva versión de la tecnología de red de Nvidia, Infiniband, con el objetivo de acelerar la compartición de datos.

-

A FondoHace 5 días

A FondoHace 5 díasPíldora roja o píldora azul

-

NoticiasHace 17 horas

NoticiasHace 17 horasQNAP estrena la segunda beta abierta de QuTS hero h6.0

-

NoticiasHace 7 días

NoticiasHace 7 díasASUS presenta el portátil para empresas, ExpertBook B3 G2

-

EntrevistasHace 6 días

EntrevistasHace 6 días«Es crucial conectar la IA a conocimiento interno y a los flujos reales de trabajo»