Noticias

Investigadores «enseñan» a los robots a conectar sentidos como la vista y el tacto

Un equipo de investigadores del Laboratorio de Inteligencia Artificial y Ciencias de la computación (CSAIL) del MIT ha conseguido desarrollar una nueva Inteligencia Artificial capaz de sentir objetos sólo con verlos, y viceversa. Para ello, los investigadores han enseñado a los robots en los que la han integrado a conectar diversos sentidos, como la vista y el tacto, de una manera similar a como lo hacen los humanos.

Además, esta nueva Inteligencia Artificial puede predecir cómo sería un objeto por su toque, solo con mirarlo. Además, es capaz de generar una representación visual de un objeto tomando únicamente como base los datos táctiles que recoge cuando lo toca.

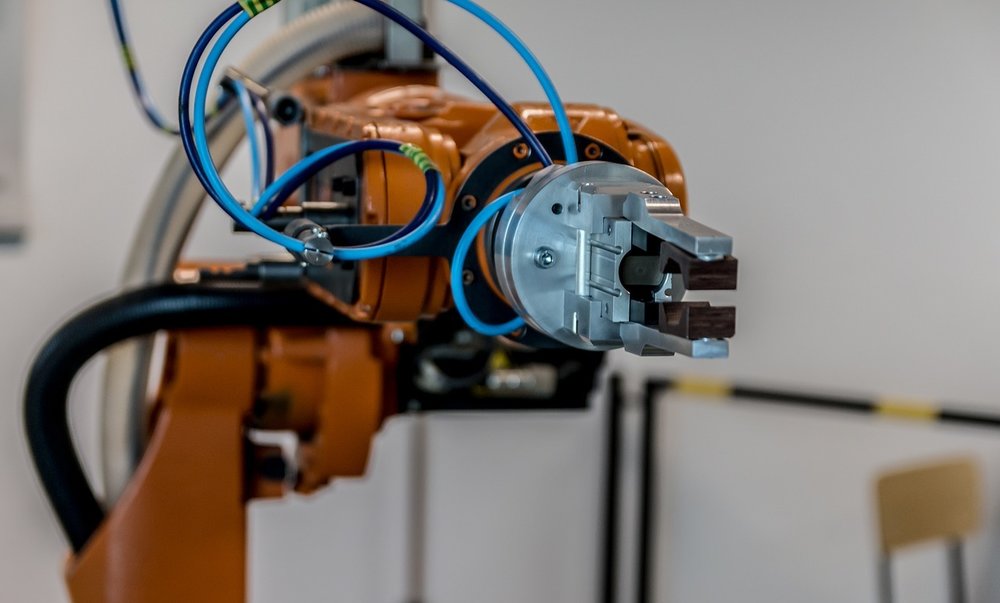

El equipo de investigadores ha utilizado en este proyecto, para los entrenamientos del sistema, un brazo robótico KUKA equipado con un sensor táctil especial, llamado GelSight. Este brazo se utilizó para tocar 200 objetos domésticos de uso cotidiano 12.000 veces, mientras los investigadores recogían la información visual y táctil. Con base en estos datos recopilados, crearon un conjunto de datos de 3 millones de imágenes visuales y táctiles, al que llamaron VisGel.

Además de VisGel, el equipo ha utilizado para desarrollar y entrenar a esta Inteligencia Artificial unos sistemas denominados redes adversarias generadoras (GAN). Estas utilizan imágenes táctiles o visuales para generar las imágenes correspondientes de la otra modalidad. Es decir, con este modelo y a partir de las imágenes de VisGel, las redes GAN consiguieron desarrollar las imágenes del tacto a partir de las de la vista, y viceversa.

El principal autor del documento sobre esta nueva inteligencia artificial, el estudiante de doctorado del CSAIL Yunzhu Li, ha subrayado que el nuevo modelo puede ayudar a que los robots puedan sostener mejor objetos del mundo real.

Además, ha explicado que «al mirar la escena, nuestro modelo puede imaginar el sentimiento del tacto de una superficie plana o un borde afilado. Al tocar a ciegas a su alrededor, nuestro modelo puede predecir la interacción con el entorno, y hacerlo únicamente a partir de sentimientos de tacto. Al aunar estos dos sentidos se puede dar más seguridad al robot, además de reducir los datos que podemos necesitar para tareas que impliquen la manipulación y agarre de objetos«.

Los investigadores que han participado en el proyecto, que presentarán su trabajo en el evento The Conference on Computer Vision and Pattern Recognition esta semana, han recordado que el conjunto de datos con el que han entrenado estaba desarrollado con base a interacciones en un entorno controlado. Y esperan mejorarlo mediante la recogida de datos en áreas más desestructuradas que contribuyan al desarrollo del conjunto de datos.

-

A FondoHace 6 días

A FondoHace 6 díasPíldora roja o píldora azul

-

NoticiasHace 20 horas

NoticiasHace 20 horasQNAP estrena la segunda beta abierta de QuTS hero h6.0

-

NoticiasHace 7 días

NoticiasHace 7 díasASUS presenta el portátil para empresas, ExpertBook B3 G2

-

EntrevistasHace 6 días

EntrevistasHace 6 días«Es crucial conectar la IA a conocimiento interno y a los flujos reales de trabajo»