Noticias

Al CEO de Nvidia no le impresiona el chip de Inteligencia Artificial de Google

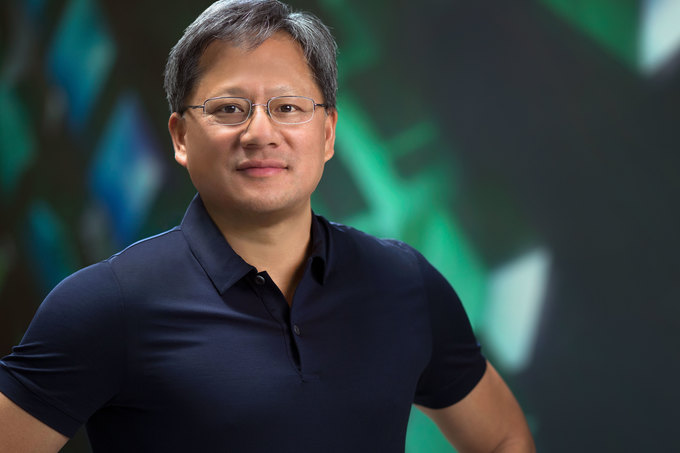

Google anunció hace unos días que había desarrollado su propio chip de Inteligencia Artificial y que planeaba utilizarlo en sus centros de datos. De nombre TPU (Tensor Processing Unit, Unidad de Proceso de Tensores), se ha desarrollado específicamente para el Deep Learning, una rama de la Inteligencia Artificial que se ocupa de que el software aprenda por si mismo a descifrar el mundo que le rodea y pueda, por ejemplo, reconocer objetor o comprender el lenguaje hablado. Estas noticias no deben haber sentado muy bien en el seno de Nvidia, que ha apostado con mucha fuerza por el desarrollo de chips gráficos para Inteligencia Artificial y ha desarrollado su nueva microarquitectura Pascal para ser clave en Machine Learning. Pero Computerworld apunta que no parece que a su CEO le haya impresionado el TPU de Google ni le haya quitado el sueño.

Nvidia, que está apostando por la Inteligencia Artificial para poder crecer, ha abandonado el mercado de desarrollo de chips en pro del de smartphones y además, tiene en los juegos y en la realidad virtual sus otros dos sectores talismán para el futuro.

En el Deep Learning hay dos aspectos: entrenamiento e inferencia. El primero consiste en proporcionar a un algoritmo grandes cantidades de datos para que pueda mejorar a la hora de recononcer un objeto. En cuanto a la inferencia, se da cuando un algoritmo aplica lo que ha aprendido a una entrada de información desconocida. Y según Huang, las GPUs son todavía mucho mejores en entrenamiento, mientras que el TPU de Google está destinado únicamente a la inferencia. El entrenamiento de un algoritmo puede llevar semanas o incluso meses, mientras que la inferencia se da en décimas de segundo. «El entrenamiento es miles de millones de veces más complicado que la inferencia», comenta Huang.

Además, Huang manifestó que la mayoría de empresas que necesitarán hacer inferencia no tienen su propio procesador, y que «es perfecto que haya empresas que quieran desarrollar sus propios chips de inferencia, no hay problema y nos encanta. Pero hay millones y millones de nodos en los centros de datos de gran escala de las empresas que no desarrollan sus propios TPUs. Pascal es la solución perfecta para ellos«.

Que Google desarrolle su propio chip no debería ser ninguna sorpresa para la industria. La tecnología es una gran ventaja para los grandes proveedores de servicios online y, de hecho, Google Facebook y Microsoft ya diseñan sus servidores. Y todavía es pronto para saber si el desarrollo del TPU del buscador ha afectado al resto de sus otras compras de chips. De hecho, sigue adquiriendo grandes cantidades de CPUs y GPUs. Mientras tanto, en Nvidia, como en otras tecnológicas, esperan que el Deep Learning y la Inteligencia Artificial se extiendan y se conviertan en tecnologías de presencia generalizada. Su CEO, Huang, ha puesto de manifiesto en Computex que los últimos 10 años han sido la era de la nube móvil, y que ahora estamos en la época de la Inteligencia Artificial. «Las empresas querrán comprender mejor las montañas de datos que están recogiendo, y eso ocurrirá gracias a la Inteligencia Artificial«.