Noticias

Nvidia lanza Orin, SoC para coches autónomos, y la versión 7 de su plataforma de deep learning TensorRT

Nada más comenzar su evento tecnológico GPU en Suzhou (China), Nvidia ha comenzado a desvelar todo tipo de novedades de la mano de su CEO, Jensen Huang. Las principales son su nuevo SoC para coches autónomos, Orin, y TensorRT 7, la nueva versión de su plataforma para inferencias de deep learning de alto rendimiento.

Además, Huang también ha anunciado que van a dar acceso open source a un paquete de modelos de Inteligencia Artificial para vehículos autónomos destinados a optimizar la toma de decisiones de manera autónoma y a mejorar la percepción visual. Además, también ha desvelado la firma de un acuerdo de colaboración en hardware con Didi Chuxing, quizá el mayor competidor de Uber.

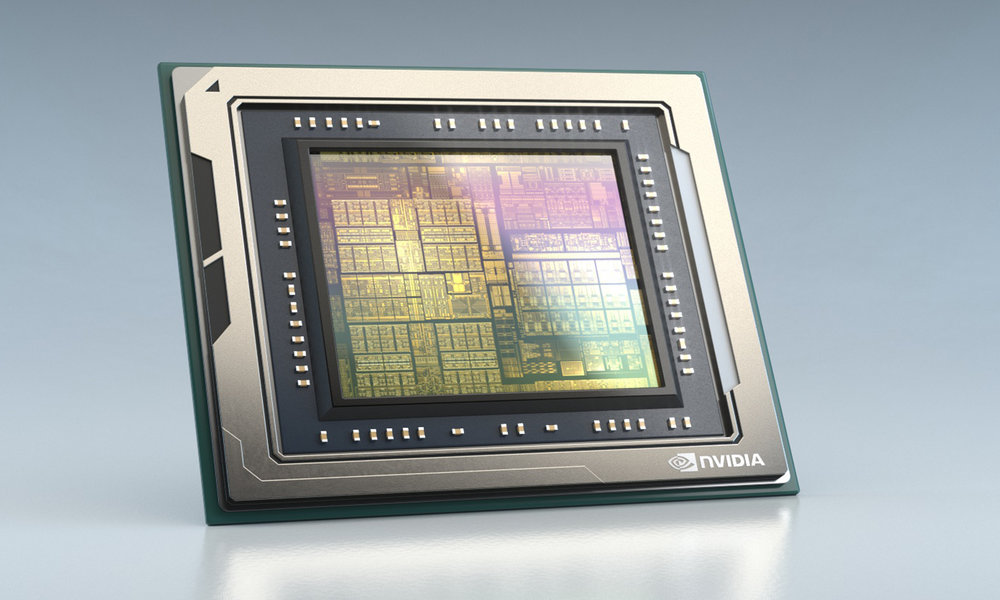

Gracias al nuevo chip Orin, la plataforma Drive AGX Orin, que llegará a aplicaciones de producción en 2022 se puede categorizar en un punto intermedio entre las otras dos plataformas que tiene Nvidia de SoCs para coches autónomos, AGX Drive Xavier y AGX Drive Pegasus. Eso sí, a diferencia de ambas, Orin se ha diseñado desde la base para ser capaz de ejecutar una gran cantidad de apps y modelos de manera simultánea.

El núcleo de Orin está compuesto por un SoC con 17 millones de transistores. Se integra con la arquitectura de chip gráfico de última generación y con los núcleos de Hércules, basados en la tecnología DynamIQ de ARM. Está diseñado para conseguir una potencia y una eficiencia un 10% superiores a las de la generación anterior. Cuenta además con núcleos aceleradores para Inteligencia Artificial y machine learning, lo que le permite alcanzar los 200 billones de operaciones por segundo, frente a los 30 de que es capaz de alcanzar el SoC Xavier.

Al igual que Pegasus, puede escalar de automátización de nivel 2 a nivel 5, y como sucede con Xavier, es programable a través de APIs y librerías. Se puede programar mediante CUDA, la plataforma de computación paralela y modelo de interfaz de programación de apps de Nvidia. También mediante la plataforma TensorRT. Cuando empiece a venderse, Orin estará disponible con diversas configuraciones, basadas todas en una única arquitectura.

Por otro lado, como hemos comentado, Nvidia proporcionará acceso open source a varios de sus modelos diseñados para el núcleo de Drive, su solución de asistencia para conductores y coches autónomos. En concreto, Nvidia pondrá bajo licencia open source los sistemas de Inteligencia Artificial que se proporcionan con Drive AGX, que están preparados para realizar tareas como el reconocimiento de las luces de los semáforos y el reconocimiento de señales. También los de detección de vehículos y peatones, percepción del camino, detección de miradas y reconocimiento de gestos.

Muchos de estos modelos se han desarrollado de manera colectiva entre varias empresas, y hace ya algún tiempo que los utilizan tanto fabricantes de coches y camiones como empresas de software y universidades. Cada uno de ellos se puede personalizar y mejorar con una suite de herramientas lanzada hace poco por Nvidia, que les permite realizar entrenamientos mediante diversas técnicas de desarrollo de machine learning.

En cuanto al acuerdo con Didi Chuxing, hará que la compañía utilice tarjetas gráficas de Nvidia en sus centros de datos para entrenar los algoritmos de machine learning que hay detrás de sus sistemas autónomos. Además, Didi apunta a que desarrollará una infraestructura de Inteligencia Artificial y lanzará servidores en la nube con GPUs virtuales, pensados para la computación, el renderizado y el juego. Mientras tanto, la división de tecnología en la nube de la compañía, Didi Cloud, adoptará un nuevo modelo de licencia de tarjetas gráficas, de la mano de Nvidia, para proporcionar servicios de cloud computing.

En cuanto a TensorRT 7, cuenta entre otras novedades con un compilador mejorado y optimizado para cargas de trabajo de inferencia en tiempo real. Estará disponible dentro de unos días en la web de TensorRT, y será gratuita para los miembros del Programa de desarrolladores de Nvidia. La plataforma se ofrece con librerías de Inteligencia Artificial Cuda-X, puede validar y desplegar una red neuronal entrenada para la inferencia independientemente del hardware, tanto si es un centro de datos o un dispositivo integrado con una tarjeta gráfica.

TensorRT acelera diversos componentes de redes, entre las que están WaveRNN de DeepMind, Tacotron 2 de Google y BERT, más de 10 veces con respecto a los enfoques basados en el procesador. Mientras tanto, mantiene la latencia por debajo del umbral de los 300 milisegundos, considerado necesario para las interacciones en tiempo real. Todo gracias, en parte, a optimizaciones destinadas a mejorar las estructuras de bucle.

-

A FondoHace 5 días

A FondoHace 5 díasPíldora roja o píldora azul

-

NoticiasHace 18 horas

NoticiasHace 18 horasQNAP estrena la segunda beta abierta de QuTS hero h6.0

-

NoticiasHace 7 días

NoticiasHace 7 díasASUS presenta el portátil para empresas, ExpertBook B3 G2

-

NoticiasHace 5 días

NoticiasHace 5 díasNextcloud Hub 26 Winter: más facilidades para migración y mejoras en rendimiento y colaboración