Noticias

Amazon Elastic Compute Cloud de segunda generación: hasta 8 GPUs NVIDIA A100

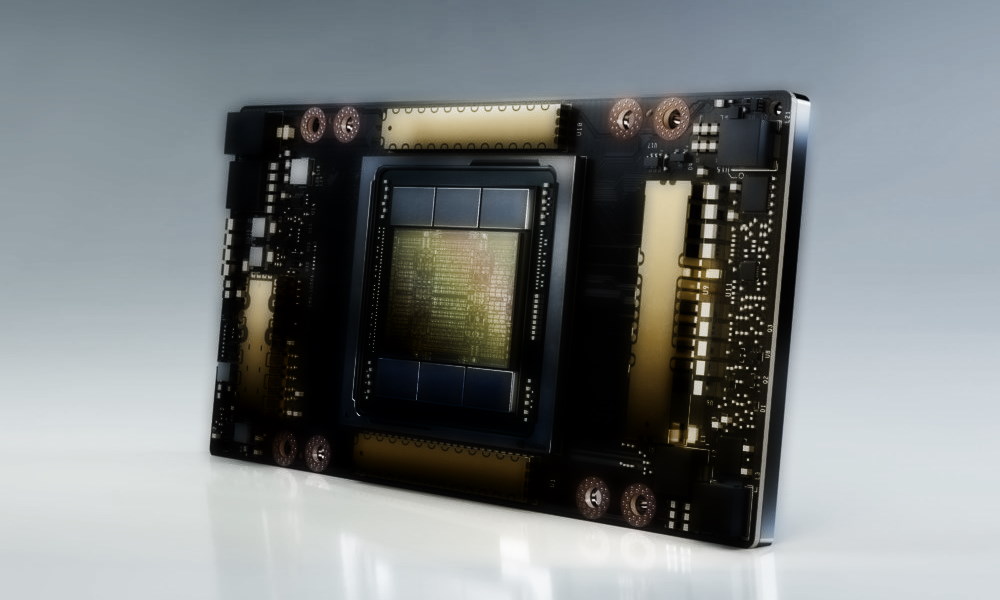

La compañía que dirige Jeff Bezos ha presentado sus nuevos sistemas Amazon Elastic Compute Cloud (Amazon EC2), apodados como P4d. Cada instancia EC2 alberga un total de ocho aceleradoras gráficas NVIDIA A100, basadas en la arquitectura Ampere, capaces de ofrecer una potencia total de 2,5 petaFLOPs en precisión mixta y equipadas con un total de 320 GB de memoria HBM.

Son datos impresionantes que confirman que estamos ante soluciones de computación en la nube de alto rendimiento, ¿pero qué CPUs ha montado la compañía en los nuevos Amazon Elastic Compute Cloud de segunda generación? Podríamos pensar en los procesadores EPYC de AMD de segunda generación, basados en la arquitectura Zen 2, y sería perfectamente comprensible, ya que estos chips ofrecen una gran potencia y tienen un valor precio-rendimiento-eficiencia realmente bueno, pero Amazon ha optado por los Intel Xeon Scalable basados en la arquitectura Cascade Lake.

En total, cada instancia P4d monta 96 CPUs virtuales Intel Xeon Cascade Lake, apoyadas por un máximo de 1,1 TB de memoria RAM, configurada en séxtuple canal, y dispondrá de un total de 8 TB de almacenamiento SSD NVMe de alto rendimiento. El salto generacional frente a los sistemas anteriores es más que evidente, pero las mejoras no se limitan a la potencia bruta, también se centran en otros aspectos como la eficiencia y el ancho de banda de red.

Según la fuente de la noticia, un Amazon Elastic Compute Cloud de segunda generación alcanzará los 400 Gbps, una cifra que multiplica por 16 el valor de la serie anterior, que estaba equipada con aceleradoras gráficas NVIDIA V100. Según Amazon, estas nuevas soluciones han conseguido duplicar el rendimiento bruto de la serie P3.

Echando un vistazo al valor que ofrecen los Amazon Elastic Compute Cloud de segunda generación nos encontramos, según los datos que ha proporcionado la compañía que dirige Jeff Bezos, con un coste de entrenamiento hasta un 60% más bajo, un aumento de rendimiento de 2,5 veces en tareas de aprendizaje profundo (con 2,5 veces más memoria disponible), el doble de rendimiento en operaciones de coma flotante en operaciones de doble precisión, un ancho de banda dieciséis veces mayor y una configuración de almacenamiento SSD de alto rendimiento configurado en local.

Esta nueva plataforma ofrece, además, una alta escalabilidad. Según Amazon, gracias al combinar la infraestructura de red sin bloqueo de escala de petabit integrada con Amazon FSx para almacenamiento de alto rendimiento Lustre, el Elastic Fabric Adapter (EFA) de AWS y NVIDIA GPUDirect RDMA (acceso remoto directo a memoria), es posible crear instancias P4d con EC2 UltraClusters, capaces de escalar a configuraciones con más de 4.000 aceleradores gráficos NVIDIA A100.

Potencia a raudales, sin duda, toda la que podamos necesitar para trabajar de forma óptima con complejas cargas asociadas a la inferencia, el entrenamiento de redes neuronales y el aprendizaje profundo. De momento AWS solo ha confirmado el precio que tienen las configuraciones base con esas ocho GPUs NVIDIA A100, 96 CPUs virtuales, 1,1 TB de RAM y 8 TB de SSD: 32,77 dólares por hora de uso, aunque es posible reducir el coste a 19,22 dólares la hora en reservas por un año. Si reservamos tres años el coste por hora baja a 11,57 dólares.

-

A FondoHace 6 días

A FondoHace 6 díasPíldora roja o píldora azul

-

NoticiasHace 1 día

NoticiasHace 1 díaQNAP estrena la segunda beta abierta de QuTS hero h6.0

-

EntrevistasHace 6 días

EntrevistasHace 6 días«Es crucial conectar la IA a conocimiento interno y a los flujos reales de trabajo»

-

A FondoHace 6 días

A FondoHace 6 díasLas grandes tecnológicas pierden 1,3 billones en 2026 por las inversiones en IA