Noticias

LIMA la apuesta de Meta para competir con ChatGPT y Bard

Meta mantiene su línea estratégica renovadora y su última operación ha sido presentar una variante de LLaMA, su modelo de inteligencia artificial, el cual se espera que alcance un rendimiento igual o superior a GPT-4 de OpenAI. LIMA (Less is More for Alingment) irrumpe como un modelo de lenguaje grande capaz de proporcionar respuestas de gran calidad partiendo de pequeñas indicaciones.

El equipo que lidera Mark Zuckerberg se encuentra entrenando a la nueva herramienta mediante un proceso preciso y riguroso, algo que la diferencia de sus principales competidoras. Basada en 65 millones de parámetros facilitados por Meta con fines de investigación en el primer trimestre del año, LIMA ha sido optimizada con apenas 1.000 prompts.

Su proceso de entrenamiento

LIMA, el nuevo LLM de Meta, se entrena en dos fases. La primera es un proceso de aprendizaje no supervisado en el que se alimenta con contenido puro, teto sin procesar, para aprender en un escenario de propósito y representación general.

La segunda es un proceso en el que los LLM adoptan una fase de depuración aplicando métodos de aprendizaje por refuerzo con retroalimentación humana. De este modo, se puede orientar su funcionamiento para desempeñar tareas específicas en base a las preferencias del usuario. No obstante, ésta es la operación más costosa en el proceso de entrenamiento de un modelo de IA, de tal modo que LIMA fue entrenado sin tener en cuenta esta fase, algo que sí sucedió en los casos de GPT-4 de OpenAI o de Bard de Google.

Con este nuevo avance, Meta viene a demostrar cómo un modelo de LLM puede trabajar partiendo de escasas indicaciones. Así pues, podrá cumplir con tareas específicas o responder a tareas nuevas que en un principio no fueron tenidas en cuenta en el conjunto de datos. Para ello, se ha tomado un millar de ejemplos de instrucciones reales; 750 procedentes de foros como Stack Exchange, Reddit y wikiHow y 250 de redacción propia por parte de los investigadores.

Sometida a una prueba real

Meta sometió su nueva herramienta de IA a un grupo de evaluadores humanos que a su vez habían trabajado previamente con otros modelos como GPT-4, DaVinci003, Claude de Anthropic y Google Bard a 200-300 solicitudes. Los resultados fueron contundentes y demostraron que LIMA producía respuestas iguales o mejores que sus principales competidores: un 43% mejor que ChatGPT, un 58% mejor que Bard y un 65% mejor que DaVinci003. Todos estos modelos se optimizaron mediante RLHF.

La conclusión a la que llegaron los investigadores de META es que la técnica RLHF no aporta grandes mejores, sino que prescindir de ella puede permitir reducir costos al entrenar un modelo de lenguaje basado en IA. Las respuestas de LIMA demostraron que, en un 88% de los casos, se cumple con los requisitos inmediatos. Así mismo, el 50% se califica como excelente.

Las carestías de LIMA

Los propios investigadores de Meta han concluido que crear conjuntos de datos con ejemplos de alta calidad supone un enfoque desafiante y difícil de escalar. También, LIMA no es tan robusto como los modelos anteriores disponibles como GPT-4, sino que aún precisa de un amplio rodaje y entrenamiento. Así pues, si se generase un prompt adversario o una muestra desafortunada durante su entrenamiento, LIMA llegaría a generar respuestas poco precisas.

A pesar de todo, la compañía se muestra satisfecha con sus investigaciones. Es por ello que Yann LeCun, jefe de investigación de IA en Meta, aseguró que el hecho de invertir en el desarrollo de nuevos LLM será clave a corto plazo, pero que deberán luchar contra la posibilidad de que perdiesen vigencia a medio plazo debido a la elevada evolución del sector.

Un resultado colaborativo

LIMA es el resultado de la colaboración de Meta con investigadores de la Universidad Carnegie Mellon, la Universidad del Sur de California y la Universidad de Tel Aviv. Esa combinación entre propuestas Open Source con una estructura interna ligera y flexible se convierte en la piedra filosofal del avance.

De hecho, recientemente Meta ha presentado los modelos Massively Multilingua Speech (MMS), cuya tecnología amplía la capacidad de las herramientas que convierten texto a voz y viceversa en más de 1.1000 idiomas, permitiéndoles identificar más de 4.000 idiomas hablados. Los MMS de Meta son modelos de código abierto.

Todo ello en plena vorágine de despidos para la compañía, que en las últimas horas ha prescindido de unas 6.000 personas. Se acumulan 27.000 puestos de trabajo suprimidos desde noviembre de 2022, cuando contaba con 87.000 empleados.

-

NoticiasHace 6 días

NoticiasHace 6 díasHuawei muestra su potencial para empresas y cloud en España en el Digital Transformation Summit

-

A FondoHace 7 días

A FondoHace 7 díasCómo asegurarse de que se puede restaurar una copia de seguridad

-

EntrevistasHace 6 días

EntrevistasHace 6 días«El low code en sí no es una tecnología o una plataforma, es una estrategia»

-

NoticiasHace 7 días

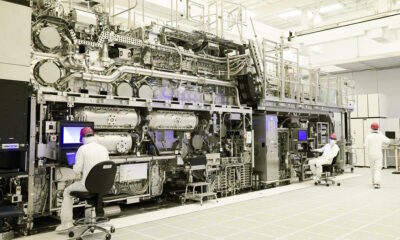

NoticiasHace 7 díasIntel Foundry sube de nivel con la litografía ultravioleta extrema de alta apertura numérica