Noticias

¿Por qué el sistema para filtrar contenidos de Twitter va a fallar?

La semana pasada, Twitter hizo públicos sus últimos resultados, que quedaron incluso por debajo de las moderadas expectativas de los inversores. Esto supuso, el mismo día, una caída de cerca del 10% de sus títulos cotizados, así como una lluvia de comentarios críticos con la actual gestión de la red social. Pocas horas antes de que esos números se hicieran públicos, nos hicimos eco de algunos aspectos que había que tener en cuenta junto con los resultados y, en la línea de los mismos, Jack Dorsey aseguró que están trabajando con sistemas de machine learning, con el fin de lograr que los resultados y tweets que se muestran siempre sean los adecuados, “llevará tiempo mostrar los resultados que queremos ver, y estamos avanzando de manera agresiva. Todo el mundo tiene la vista puesta en Twitter“. Esto entronca con su interés en acabar con los contenidos inadecuados (amenazas, insultos, acoso, etcétera), uno de los principales problemas de la red. Sin embargo, Mike Elgan ha publicado una interesante columna en Computerworld en la que, antes incluso de que ese sistema ya esté operativo, adelanta que no va a funcionar. ¿Por qué?

Recuerda Elgan que, hace ya un par de años, el entonces CEO de Twitter, Dick Costolo, ya apuntaba al problema de los mensajes de odio, así como al spam, como uno de los principales problemas de la red social y, por lo tanto, a que esta era (y sigue siendo) la causa por la que el crecimiento de usuarios es prácticamente plano, y cada vez más anunciantes no quieren ver sus mensajes rodeados de insultos, amenazas y contenidos similares. En esa línea, hace solo unos días el vicepresidente de ingeniería de la compañía, Ed Ho, anunció algunos cambios dirigidos a acabar con trolls, haters, spammers, misóginos, racistas e idiotas, en algo que se ha convertido en el principal objetivo, y que se sostiene en los siguientes puntos:

- Identificar a aquellos usuarios cuyas cuentas ya han sido suspendidas, con el fin de evitar que puedan crear nuevas cuentas con las mismas intenciones.

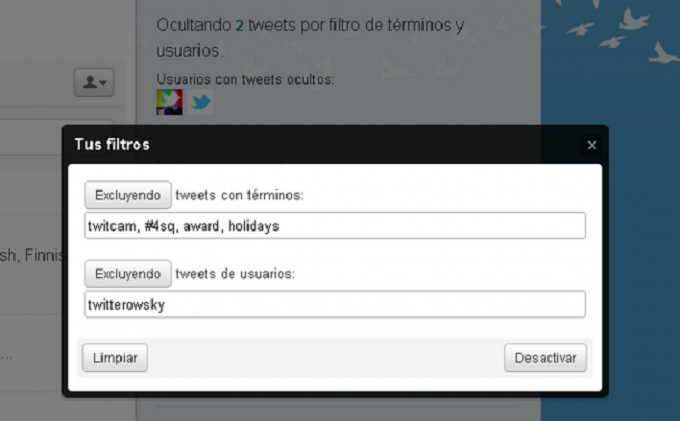

- Eliminar, de los resultados de búsqueda, aquellos tweets con contenido potencialmente sensible o molesto, o que hayan sido publicados por cuentas bloqueadas o silenciadas. No obstante, los usuarios podrán desactivar ese filtro si lo desean.

- Al mostrar las conversaciones (respuestas a un tweet), Twitter automáticamente contraerá las respuestas que sean potencialmente molestas, de manera que quienes quieran verlas tengan que hacer click en ellas.

El punto es que, por muchos esfuerzos que se hayan llevado a cabo hasta el momento, los sistemas de moderación automáticos aún están muy lejos de alcanzar la efectividad de la moderación llevada a cabo por personas (lo que incluye a los propios usuarios). Dicho de otra manera, el mejor sistema de moderación es que los usuarios puedan eliminar las respuestas de los trolls. Está claro que este sistema tampoco es perfecto, pero su adopción por el resto de redes sociales, en las que los creadores de una publicación pueden eliminar las respuestas inadecuadas, demuestra que es un modelo que resulta bastante fiable. Así pues, al menos hasta que los sistemas de filtrado automático estén mucho más perfeccionados que en la actualidad, los usuarios deberían tener la posibilidad de desvincular respuestas de sus publicaciones.

Y es que, incluso Google, cuya experiencia desarrollando algoritmos de inteligencia artificial es de las más destacables, tiene experiencias negativas en lo que se refiere a la moderación automática de contenidos. Por ejemplo, el autor de la columna, cita un caso experimentado por él mismo en Google Plus. En una ocasión, colgó una imagen, invitando a sus seguidores a que intentaran averiguar de qué se trataba. Lo curioso es que la primera respuesta que acertaba, fue marcada por Google como «de baja calidad», por lo que fue ocultada al resto de usuarios. Sin embargo, un poco más abajo en la misma conversación, otro usuario respondió poniendo un guión «–» como una respuesta. Y a diferencia de lo ocurrido con la respuesta correcta, a Google le pareció que ésta sí que tenía la calidad necesaria y, por lo tanto, la mostró con normalidad.

Así pues, es formidable que Twitter pretenda acabar con este tipo de mensajes, pero o abre el sistema a la participación del resto de usuarios y, sobre todo, permite que el creador de un tweet pueda desvincular (o incluso eliminar) determinadas respuestas al mismo (aunque estas, a posteriori, sean revisadas de manera manual por algún operador de la empresa), el sistema de filtrado basado exclusivamente en inteligencia artificial las tiene todas consigo para convertirse en un sonado fallo.

-

EntrevistasHace 6 días

EntrevistasHace 6 días«No tiene sentido una estrategia tecnológica que no encaje al 100% con la del CEO»

-

NoticiasHace 7 días

NoticiasHace 7 díasIberdrola, en busca de socios para construir centros de datos

-

NoticiasHace 6 días

NoticiasHace 6 díasAMD lanza los procesadores Ryzen 8000 Pro con NPU y GPU integrada

-

A FondoHace 6 días

A FondoHace 6 díasDe HAL a Matrix: 9 películas «tecnológicas» que no te puedes perder