Noticias

El superordenador Frontier logra entrenar un modelo de lenguaje de un billón de parámetros con 3.072 GPUs

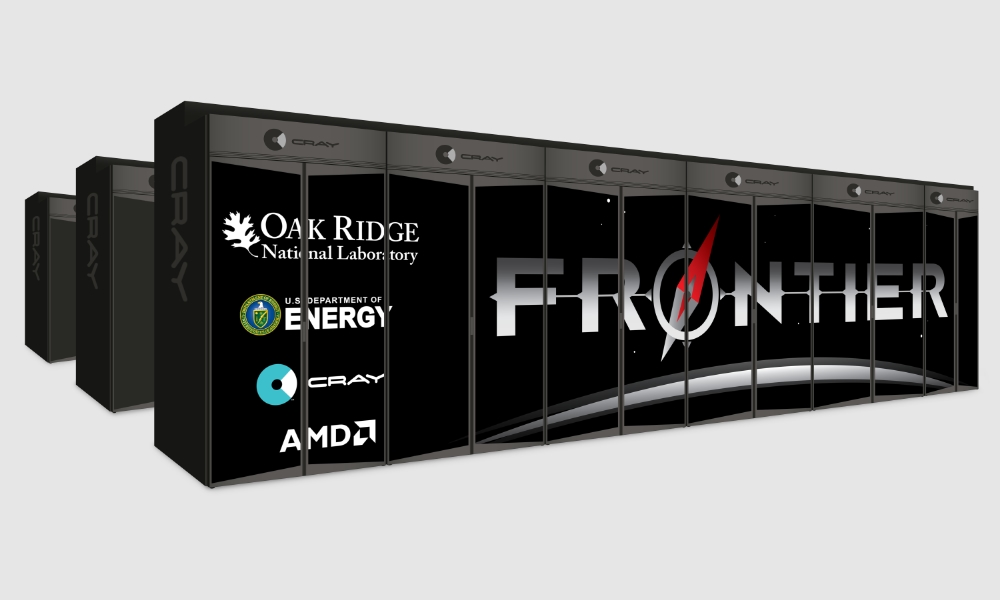

El superordenador Frontier ha logrado, de la mano de un equipo de investigadores, reducir de manera significativa el número de GPUs que hacen falta para entrenar un modelo grande de lenguaje, con una gran cantidad de parámetros. Para demostrarlo, los investigadores encargados de su operación, en el Laboratorio Nacional Oak Ridge de Estados Unidos, han publicado un artículo en el que ofrecen detalles de cómo han conseguido entrenar uno, con un billón de parámetros, en el superordenador Frontier, utilizando solo 3.072 de sus 37.888 GPUs.

¿Qué quiere decir esto? Pues que los investigadores de dicho laboratorio consiguieron entrenar un modelo de una envergadura muy similar a la de GPT-4 solo con un 8% aproximadamente de la potencia de computación de Frontier.

El equipo de investigadores ha conseguido también entrenar otro, de 175.000 millones de parámetros, con 1.024 de las GPUs del superordenador. Sin duda, un avance notable en un campo que hasta ahora hace necesario contar con ingentes recursos de computación y memoria para el entrenamiento de modelos grandes de lenguaje.

Para lograrlo, los investigadores trabajaron con técnicas de entrenamiento de datos en paralelo, con el objetivo de reducir la comunicación entre capas de nodos y gestionar las limitaciones de memoria. También trabajaron en la eficiencia de las GPUs en cuanto a computación. Esto llevó a los investigadores a utilizar un sistema llamado «ajuste de hiperparámetro» para descubrir las estrategias más eficientes para la entrenamiento de modelos grandes de lenguaje, y conseguir distribuir el entrenamiento del modelo de manera más eficiente.

Según los resultados, los rendimientos de las GPUs llegaron al 31,96% con el modelo de un billón de parámetros, y al 36,14% para el de 175.000 millones de parámetros. Además, para ambos modelos, los investigadores consiguieron un 100% de eficiencia en escalado débil y de un 89% en escalado fuerte en el modelo de 175.000 millones de parámetros y del 87% en el del modelo de un billón de parámetros.

Eso sí, lo que no detalla el modelo es cuánto tiempo tardaron en entrenar el modelo utilizando las GPUs mencionadas del superordenador Frontier, que en noviembre de 2023 consiguió el primer puesto en la lista de los 500 superordenadores más potentes del mundo.

-

A FondoHace 5 días

A FondoHace 5 díasPíldora roja o píldora azul

-

NoticiasHace 5 horas

NoticiasHace 5 horasQNAP estrena la segunda beta abierta de QuTS hero h6.0

-

NoticiasHace 6 días

NoticiasHace 6 díasASUS presenta el portátil para empresas, ExpertBook B3 G2

-

EntrevistasHace 5 días

EntrevistasHace 5 días«Es crucial conectar la IA a conocimiento interno y a los flujos reales de trabajo»