Noticias

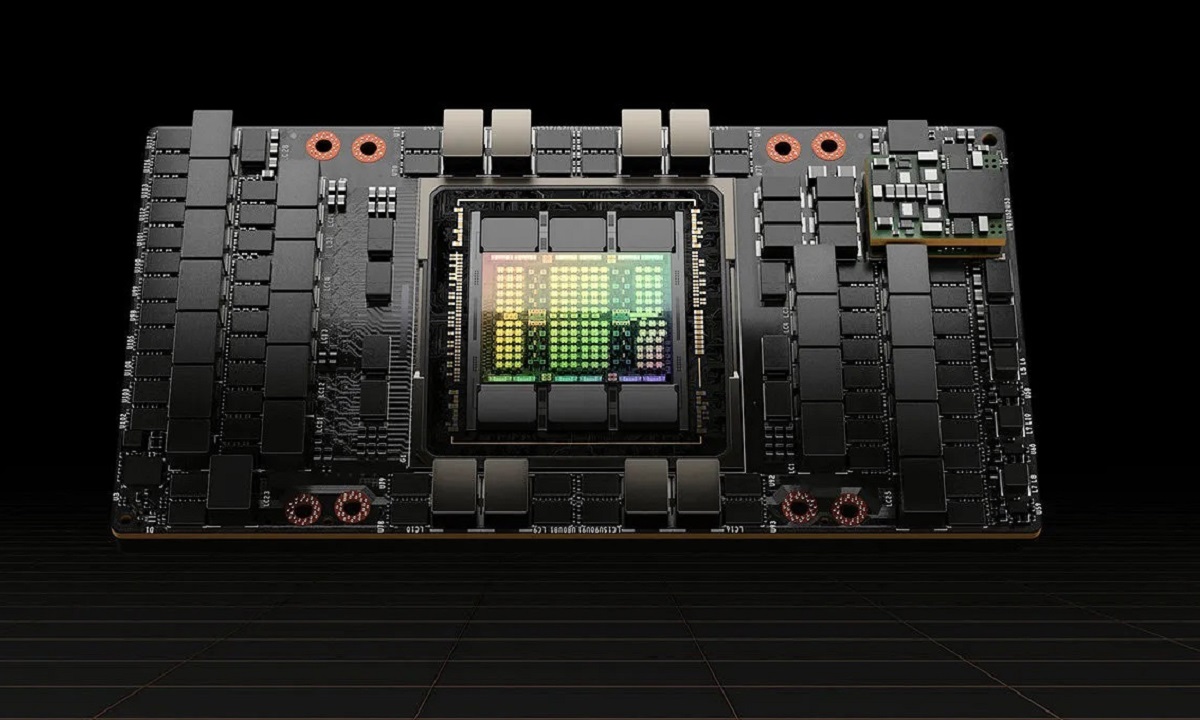

NVIDIA utiliza IA para mejorar el diseño de sus GPUs, y Hopper es un ejemplo de ello

El pasado mes de abril vimos que la IA tenía mucho potencial en el sector de los semiconductores. Fue NVIDIA la que confirmó que esta tecnología era capaz de crear mejores diseños de chips, y que podía hacerlo en menos tiempo que un equipo de hasta diez personas. No hay duda de que esta información era muy interesante, y de hecho encajaba con las afirmaciones de otros gigantes del sector, como Google por ejemplo, ¿pero qué implicaciones reales había tenido?

En aquel momento no podíamos contestar a esa pregunta, pero gracias a un nuevo artículo que ha compartido NVIDIA en su web oficial, dedicada a desarrolladores, hemos podido ver que la compañía ya está aprovechando de verdad el potencial de la IA para diseñar y desarrollar GPUs superiores a las que pueden crear los humanos, y que la GPU Hopper, actual buque insignia de los de verde para el sector profesional, es un claro ejemplo de ello, ya que cuenta con casi 13.000 instancias de circuitos que han sido diseñados por completo utilizando IA.

Las GPUs de NVIDIA se diseñan principalmente recurriendo a lo que se conoce como EDA, es decir, Diseño Electrónico Automatizado por sus siglas en inglés, pero con la ayuda de una IA que utiliza la metodología PrefixRL, una optimización de los circuitos de prefijos paralelos que recurre al aprendizaje profundo de refuerzo. Esto permite a NVIDIA diseñar chips más pequeños, más rápidos y más eficientes que ofrecen, a su vez, un mayor rendimiento.

Comparado con la metodología EDA estándar las diferencias son sustanciales. Según NVIDIA el uso de PrefixRL le permitió conseguir un diseño de circuitos aritméticos que encajaban sin problemas dentro del nivel «deseable», es decir, tenían un área reducida, un alto rendimiento y un bajo consumo, y lo mejor de todo es que la IA fue capaz de reducir en un 25% el área total de esos casi 13.000 circuitos en comparación con el diseño obtenido mediante EDA.

Muy interesante, pero esta tecnología también es muy exigente. Según NVIDIA para que funcione de una manera óptima es necesario contar, por cada GPU a diseñar, con un sistema de computación que cuenta con 256 CPUs y 32.000 horas de trabajo a nivel de GPUs. Para solventar el problema que representa esa alta exigencia a nivel de hardware NVIDIA ha creado Raptor, una plataforma interna especializada en el aprendizaje profundo de refuerzo distribuido que ofrece el rendimiento necesario, y que tiene además una elevada escalabilidad. Podemos encontrar más información en la web de NVIDIA.

-

A FondoHace 6 días

A FondoHace 6 díasPíldora roja o píldora azul

-

NoticiasHace 1 día

NoticiasHace 1 díaQNAP estrena la segunda beta abierta de QuTS hero h6.0

-

NoticiasHace 7 días

NoticiasHace 7 díasASUS presenta el portátil para empresas, ExpertBook B3 G2

-

EntrevistasHace 6 días

EntrevistasHace 6 días«Es crucial conectar la IA a conocimiento interno y a los flujos reales de trabajo»