Noticias

Karina García, otra historia de éxito en YouTube

La primera gran evolución de Internet tras su globalización fue, todos lo recordamos, la web 2.0. Un cambio con el que la generación de los contenidos dejó de recaer de un lado (los creadores de las páginas web, fueran estas del tipo que fueran) y pasaron a ser los usuarios los responsables de los mismos. Por aquellos entonces se empezó a hablar de UGC (User Generated Content). Y, aunque en un primer momento, se limitaba casi exclusivamente a texto (especialmente en foros y webs colaborativas) e imágenes solo de manera muy puntual, el rápido crecimiento (y su consecuente abaratamiento) en la capacidad de almacenamiento de los centros de datos, así como el aumento en el ancho de banda en todos los puntos facilitaron que, poco a poco, fuera posible compartir otro tipo de contenidos. Y entonces llegó YouTube.

El popular servicio de vídeo online, que posteriormente ha evolucionado adoptando muchas funciones de red social, fue creado en febrero de 2005, y poco más de un año y medio después fue adquirido por Google, que pagó nada menos que 1.650 millones de dólares (una compra que muchos analistas consideraron absurda…). Desde entonces, la plataforma se ha convertido en la principal elección para la publicación de vídeos, lo que ha dado lugar a que múltiples historias de éxito se hayan construido a su alrededor. Tanto es así que incluso se ha creado y profesionalizado la figura del youtuber, un concepto puesto en marcha por la compañía en 2011 que pretendía proporcionar ingresos (basados principalmente en Google Adsense), y que ha dado lugar a un sinfín de historias de éxito, principalmente de adolescentes y jóvenes, que han convertido la profesionalización de sus publicaciones en una nada desdeñable fuente de ingresos.

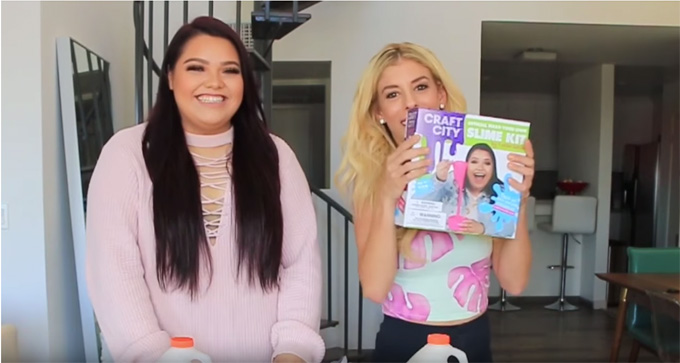

Hoy CNBC dedica un artículo a uno de los últimos y más claros ejemplos de ese tipo de éxito que pueden ofrecer las redes sociales y, especialmente, YouTube. Hablamos de Karina García, una joven de 23 años aficionada al popular DIY (do it yourself, hazlo tú mismo), un tipo de vídeos con mucho éxito en YouTube, y que gracias a su habilidad con el slime, una masa gelatinosa, elástica y moldeable, y la simpatía que transmite en sus vídeos, ha logrado alcanzar ya los 6,7 millones de suscriptores, además de haber provocado un incremento del 50% en las ventas de esta llamativa masilla. Además, gracias a la popularidad que ha obtenido, no solo logra un buen nivel de ingresos (proporcionados principalmente por los patrocinadores de sus vídeos), sino que también ha podido lanzar al mercado su propio kit DIY de slime, que espera complementar próximamente con otros dedicados a las bombas de baño (esas esferas que, al introducirlas en la bañera, son efervescentes y liberan aromas y sales de baño) y pintalabios, Todo, por supuesto, para que las personas que los adquieran puedan hacer sus creaciones personales.

Este, el de Karina García, es otro de esos casos que nos recuerdan que, al analizar el futuro (tanto el que ya está llegando como aquel para el que todavía falta mucho), nos faltan muchos elementos para poder hacer predicciones fiables. ¿Quién habría imaginado, hace solo diez años, que publicar vídeos en YouTube podría convertirse en una manera de ganarse la vida? Nadie, y sin embargo a día de hoy existe incluso un juego en el que nuestro desafío es lograr convertirnos en un youtuber de éxito. Además, y en este caso, hay un elemento adicional que debemos tener muy en cuenta, especialmente si ya peinamos canas: los adultos simplemente han puesto en marcha una plataforma, y han sido los jóvenes los que han decidido darle este uso. Esto, en mi opinión, es un ejemplo perfecto de la razón por la que hay que tener en cuenta todos los puntos de vista. Y es que a mí, personalmente, jamás se me habría ocurrido este tipo de comunicación, pero millennials y post-millennials (generaciones Y y Z) han inventado un nuevo uso para una herramienta ya existente, y la han convertido en su medio de comunicación.

¿Y qué comunican? Pues en el caso de Karina García, gran parte de los casi 230 (alrededor de 100 dedicados al slime) vídeos que ha publicado en su canal son tutoriales (a veces sola y en otras ocasiones acompañada) que, y este es un aspecto también muy importante del fenómeno youtuber, consiguen romper la brecha generacional (algo que no consiguen otro tipo de contenidos), atrayendo a un público mucho más heterogéneo. Y es que al igual que ocurre con, por ejemplo, los contenidos dedicados al maquillaje (un tema estrella dentro de YouTube), la audiencia potencial es muy, muy elevada. Un volumen de audiencia que, a su vez, atrae a los anunciantes, creando una suerte de círculo virtuoso, y que en este caso concreto permite que una joven de 23 años, que hasta hace solo dos no tenía nada claro su futuro, actualmente declare unos ingresos mensuales de seis dígitos. Algo que consigue dedicando, eso sí, bastante trabajo. Una vez grabados los brutos (todo el material en vídeo, antes de la edición), puede llegar a dedicar hasta cinco horas para editar y montar un vídeo de menos de 10 minutos. Un tiempo que debemos sumar a la preproducción (diseño de la idea, planificación) y a la grabación, en la que debemos incluir distintas tomas, planos de recursos, planos fijos, locución (que se graba sobre el vídeo ya editado. Y esto debemos multiplicarlo por tres, que es el número de vídeos que García se plantea como objetivo subir cada semana a su canal. No está nada mal para una persona que, por cierto, se confiesa bastante tímida.

-

A FondoHace 5 días

A FondoHace 5 díasPíldora roja o píldora azul

-

NoticiasHace 14 horas

NoticiasHace 14 horasQNAP estrena la segunda beta abierta de QuTS hero h6.0

-

NoticiasHace 6 días

NoticiasHace 6 díasASUS presenta el portátil para empresas, ExpertBook B3 G2

-

NoticiasHace 5 días

NoticiasHace 5 díasNextcloud Hub 26 Winter: más facilidades para migración y mejoras en rendimiento y colaboración