Noticias

Intel lleva sus novedades para Inteligencia Artificial a su evento AI Summit 2019

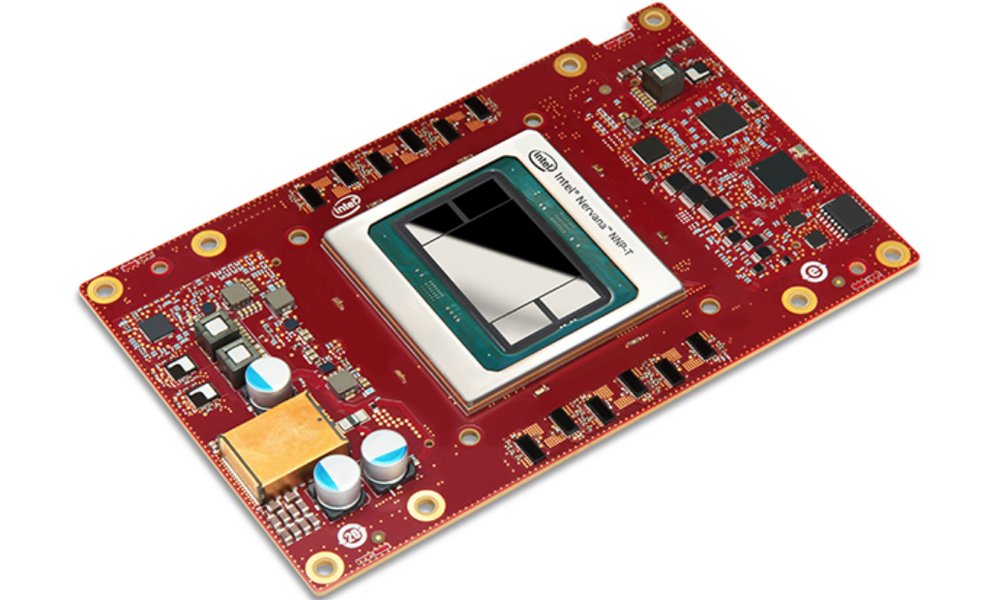

Intel ha presentado sus últimas novedades pensadas para trabajar en Inteligencia Artificial en su evento AI Summit 2019, celebrado ayer en San Francisco. Entre ellas está una versión mejorada de su unidad de proceso de visión Movidius (VPU), cuyo nombre en clave es Keem Bay, así como sus procesadores para entrenamiento en redes neuronales Nervana NNP-T y para inferencia, Nervana NNP-I. La compañía también aprovechó para presentar, entre otros avances software en este campo, Edge AI DevCloud, un sistema para prototipado de IA en edge con OpenVINO.

Con estas novedades, Intel subraya su apuesta por la Inteligencia Artificial, tanto en la nube como en los centros de datos y en el edge. Se trata de un sector muy apetecible para la compañía, que ya le reporta unos ingresos anuales de 3.500 millones de dólares, según ha manifestado en el evento Naveen Rao, Vicepresidente de Inteligencia Artificial y Responsable del Grupo de productos de Inteligencia Artificial de la compañía.

La primera de las novedades, la versión mejorada de Movidius, verá la luz en la primera mitad de 2020. Esta nueva VPU ofrece como novedades con respecto a la Movidius original diversas funciones de arquitectura pensadas para la mejora de la eficiencia y el rendimiento del chip. Así, Keem Bay proporciona un rendimiento para inferencia en bruto diez veces superior al conseguido por las VPU de primera generación de Intel.

Además, según las pruebas que se le han realizado, Keem Bay ofrecerá un rendimiento en bruto que supera en cuatro veces el del SOC TX2 de Nvidia. Además, puede ofrecer el mismo rendimiento bruto que el SOC Xavier de Nvidia, pero con un consumo cinco veces menor. Está diseñado para medios en edge, visión por computador y aplicaciones de inferencia. Tan solo mide 72 milímetros, y puede instalarse y utilizarse en multitud de dispositivos, desde robots hasta tarjetas PCIe.

En cuanto a los chips para entrenamiento e inferencia de Intel, NNP-T1000 y NNP-I1000 respectivamente, son los primeros ASICs que desarrolla Intel para deep learning complejo, tanto para la nube como para centros de datos de clientes. El primero de ellos está diseñado para entrenamiento de alta eficiencia de aplicaciones de deep learning del mundo real. Se caracteriza, según Intel, por no perder ancho de banda de comunicaciones cuando se pasa de un sistema integrado en el chasis de o tarjetas a un sistema de chasis híbrido de 12 tarjetas.

Por otro lado, el NNP-I se ha diseñado para ejecución en tiempo casi real, de inferencia de alto volumen y baja inferencia. Según la compañía, es capaz de procesar 10.576 imágenes por segundo en un escenario offline, y 10.263 imágenes por segundo en un escenario de servidor para su clasificación en ResNet-50 1.5 al emplear el formato ONNX (Open Neural Network Exchange).

El procesador NNP-I tendrá soporte por parte de OpenVINO, un conjunto de herramientas diseñadas para llevar la visión por ordenador y la inferencia de deep learning para aplicaciones de visión en edge. Intel anunció en el AI Summit, además, Edge AI DevCloud, que permite a los desarrolladores prototipar y probar soluciones de Inteligencia Artificial para dispositivos en local, como drones y cámaras, en un amplio rango de procesadores de Intel antes de que se hagan con el hardware necesario para ejecutarlas. Los desarrolladores pueden, con Edge AI DevCloud, utilizar herramientas y frameworks ya existentes para probar y optimizar modelos en OpenVINO para diverso hardware de Intel.

Según Jonathan Ballon, Vicepresidente de IoT de Intel, «con el lanzamiento de Edge AI DevCloud, los clientes podrán modelar y hacer simulaciones en la herramienta de banco de pruebas de deep learning que lanzamos este verano, para hacer después despliegues gratis en la nube de desarrollo con una variedad de configuraciones hardware distintas para descubrir cuál es el mejor esquema de hardware para ellos«. Edge AI DevCloud se lanzó hace seis meses en fase de pruebas, y actualmente ya lo utilizan 2.700 clientes.

-

A FondoHace 6 días

A FondoHace 6 díasPíldora roja o píldora azul

-

NoticiasHace 1 día

NoticiasHace 1 díaQNAP estrena la segunda beta abierta de QuTS hero h6.0

-

EntrevistasHace 6 días

EntrevistasHace 6 días«Es crucial conectar la IA a conocimiento interno y a los flujos reales de trabajo»

-

A FondoHace 6 días

A FondoHace 6 díasLas grandes tecnológicas pierden 1,3 billones en 2026 por las inversiones en IA